Datenkomprimierung – Wikipedia

Verfahren zum Kodieren von Informationen mit weniger Bits als die ursprüngliche Darstellung

Bei der Signalverarbeitung, Datenkompression, Quellcodierung,[1] oder Bitratenreduktion ist der Prozess des Kodierens von Informationen mit weniger Bits als die ursprüngliche Darstellung.[2] Jede bestimmte Komprimierung ist entweder verlustbehaftet oder verlustfrei. Die verlustfreie Komprimierung reduziert Bits, indem statistische Redundanz identifiziert und eliminiert wird. Bei der verlustfreien Komprimierung gehen keine Informationen verloren. Die verlustbehaftete Komprimierung reduziert Bits, indem unnötige oder weniger wichtige Informationen entfernt werden.[3] Typischerweise wird ein Gerät, das Datenkomprimierung durchführt, als Encoder bezeichnet, und eines, das die Umkehrung des Prozesses (Dekomprimierung) durchführt, als Decoder.

Das Verringern der Größe einer Datendatei wird oft als Datenkomprimierung bezeichnet. Im Zusammenhang mit der Datenübertragung wird dies als Quellcodierung bezeichnet; Verschlüsselung an der Quelle der Daten, bevor diese gespeichert oder übertragen werden.[4] Die Quellencodierung sollte nicht mit der Kanalcodierung zur Fehlererkennung und -korrektur oder der Zeilencodierung, dem Mittel zum Abbilden von Daten auf ein Signal, verwechselt werden.

Die Komprimierung ist nützlich, da sie die zum Speichern und Übertragen von Daten erforderlichen Ressourcen reduziert. Bei den Komprimierungs- und Dekompressionsprozessen werden Rechenressourcen verbraucht. Die Datenkomprimierung unterliegt einem Kompromiss zwischen Raum-Zeit-Komplexität. Zum Beispiel kann ein Komprimierungsschema für Video teure Hardware erfordern, damit das Video schnell genug dekomprimiert wird, um während der Dekomprimierung angezeigt zu werden, und die Option, das Video vollständig zu dekomprimieren, bevor es angesehen wird, kann unpraktisch sein oder zusätzlichen Speicher erfordern. Der Entwurf von Datenkomprimierungsschemata beinhaltet Kompromisse zwischen verschiedenen Faktoren, einschließlich des Komprimierungsgrads, des Ausmaßes der eingeführten Verzerrung (bei Verwendung verlustbehafteter Datenkomprimierung) und der Rechenressourcen, die zum Komprimieren und Dekomprimieren der Daten erforderlich sind[5]

Verlustfrei[edit]

Verlustfreie Datenkomprimierungsalgorithmen nutzen normalerweise statistische Redundanz, um Daten ohne Informationsverlust darzustellen, sodass der Prozess reversibel ist. Eine verlustfreie Komprimierung ist möglich, da die meisten realen Daten statistische Redundanz aufweisen. Ein Bild kann beispielsweise Farbbereiche aufweisen, die sich über mehrere Pixel nicht ändern; anstatt “rotes Pixel, rotes Pixel, …” zu codieren, können die Daten als “279 rote Pixel” codiert werden. Dies ist ein grundlegendes Beispiel für die Lauflängencodierung; Es gibt viele Schemata zur Reduzierung der Dateigröße durch Eliminierung von Redundanz.

Die Komprimierungsmethoden Lempel-Ziv (LZ) gehören zu den beliebtesten Algorithmen für die verlustfreie Speicherung.[6]DEFLATE ist eine Variation von LZ, die für die Dekompressionsgeschwindigkeit und das Kompressionsverhältnis optimiert ist, aber die Kompression kann langsam sein. Mitte der 1980er Jahre wurde der Lempel-Ziv-Welch (LZW)-Algorithmus nach der Arbeit von Terry Welch schnell zur Methode der Wahl für die meisten universellen Kompressionssysteme. LZW wird in GIF-Bildern, Programmen wie PKZIP und Hardwaregeräten wie Modems verwendet.[7] LZ-Methoden verwenden ein tabellenbasiertes Komprimierungsmodell, bei dem Tabelleneinträge durch wiederholte Datenstrings ersetzt werden. Bei den meisten LZ-Methoden wird diese Tabelle dynamisch aus früheren Daten in der Eingabe generiert. Die Tabelle selbst ist oft Huffman-kodiert. Grammatikbasierte Codes wie dieser können sich stark wiederholende Eingaben äußerst effektiv komprimieren, zum Beispiel eine biologische Datensammlung derselben oder nahe verwandter Arten, eine riesige versionierte Dokumentensammlung, Internetarchivierung usw eine kontextfreie Grammatik, die eine einzelne Zeichenfolge ableitet. Andere praktische Grammatikkompressionsalgorithmen umfassen Sequitur und Re-Pair.

Die stärksten modernen verlustfreien Kompressoren verwenden probabilistische Modelle, wie z. B. Vorhersage durch partielles Matching. Die Burrows-Wheeler-Transformation kann auch als indirekte Form der statistischen Modellierung angesehen werden.[8] In einer weiteren Verfeinerung der direkten Verwendung probabilistischer Modellierung können statistische Schätzungen mit einem Algorithmus namens arithmetische Codierung gekoppelt werden. Die arithmetische Codierung ist eine modernere Codiertechnik, die die mathematischen Berechnungen einer endlichen Maschine verwendet, um eine Folge codierter Bits aus einer Reihe von Eingabedatensymbolen zu erzeugen. Es kann im Vergleich zu anderen Techniken wie dem bekannteren Huffman-Algorithmus eine überlegene Komprimierung erreichen. Es verwendet einen internen Speicherzustand, um die Notwendigkeit zu vermeiden, eine Eins-zu-Eins-Zuordnung einzelner Eingabesymbole auf unterschiedliche Darstellungen durchzuführen, die eine ganze Zahl von Bits verwenden, und löscht den internen Speicher erst, nachdem die gesamte Zeichenfolge von Datensymbolen kodiert wurde . Die arithmetische Codierung eignet sich besonders gut für adaptive Datenkompressionsaufgaben, bei denen die Statistiken variieren und kontextabhängig sind, da sie leicht mit einem adaptiven Modell der Wahrscheinlichkeitsverteilung der Eingabedaten gekoppelt werden kann. Ein frühes Beispiel für die Verwendung arithmetischer Codierung war ein optionales (aber nicht weit verbreitetes) Merkmal des JPEG-Bildcodierungsstandards.[9] Es wurde seitdem in verschiedenen anderen Designs verwendet, darunter H.263, H.264/MPEG-4 AVC und HEVC für die Videocodierung.[10]

In den späten 1980er Jahren wurden digitale Bilder immer häufiger und Standards für die verlustfreie Bildkomprimierung entstanden. In den frühen 1990er Jahren wurden verlustbehaftete Komprimierungsverfahren weit verbreitet.[11] Bei diesen Schemata wird ein gewisser Informationsverlust in Kauf genommen, da das Weglassen nicht wesentlicher Details Speicherplatz sparen kann. Es gibt einen entsprechenden Kompromiss zwischen dem Erhalten von Informationen und der Reduzierung der Größe. Verlustbehaftete Datenkompressionsschemata werden durch Forschung dazu entwickelt, wie Menschen die fraglichen Daten wahrnehmen. Beispielsweise reagiert das menschliche Auge empfindlicher auf subtile Helligkeitsschwankungen als auf Farbschwankungen. Die JPEG-Bildkomprimierung funktioniert teilweise durch Abrunden nicht wesentlicher Informationsbits.[12] Eine Reihe beliebter Komprimierungsformate nutzen diese Wahrnehmungsunterschiede, darunter Psychoakustik für Ton und Psychovisualisierung für Bilder und Videos.

Die meisten Formen der verlustbehafteten Kompression basieren auf Transformationscodierung, insbesondere der diskreten Kosinustransformation (DCT). Es wurde erstmals 1972 von Nasir Ahmed vorgeschlagen, der 1973 zusammen mit T. Natarajan und KR Rao einen funktionierenden Algorithmus entwickelte, bevor er ihn im Januar 1974 einführte.[13][14] DCT ist die am weitesten verbreitete verlustbehaftete Komprimierungsmethode und wird in Multimediaformaten für Bilder (wie JPEG und HEIF) verwendet.[15]Video (wie MPEG, AVC und HEVC) und Audio (wie MP3, AAC und Vorbis).

In Digitalkameras wird eine verlustbehaftete Bildkomprimierung verwendet, um die Speicherkapazitäten zu erhöhen. Ebenso verwenden DVDs, Blu-ray und Streaming-Video verlustbehaftete Videocodierungsformate. Verlustbehaftete Komprimierung wird häufig in Video verwendet.

Bei der verlustbehafteten Audiokompression werden Verfahren der Psychoakustik verwendet, um nicht hörbare (oder weniger hörbare) Komponenten des Audiosignals zu entfernen. Die Kompression der menschlichen Sprache wird oft mit noch spezialisierteren Techniken durchgeführt; Sprachcodierung wird als separate Disziplin von der allgemeinen Audiokomprimierung unterschieden. Sprachcodierung wird beispielsweise in der Internettelefonie verwendet, Audiokomprimierung wird zum Rippen von CDs verwendet und von den Audioplayern decodiert.[8]

Eine verlustbehaftete Komprimierung kann zu Generationsverlusten führen.

Die theoretische Grundlage für die Komprimierung bilden die Informationstheorie und insbesondere die algorithmische Informationstheorie für die verlustfreie Komprimierung und die Rate-Distortion-Theorie für die verlustbehaftete Komprimierung. Diese Studienrichtungen wurden im Wesentlichen von Claude Shannon geschaffen, der Ende der 1940er und Anfang der 1950er Jahre grundlegende Arbeiten zu diesem Thema veröffentlichte. Andere mit Komprimierung verbundene Themen umfassen Codierungstheorie und statistische Inferenz.[16]

Maschinelles Lernen[edit]

Zwischen maschinellem Lernen und Komprimierung besteht ein enger Zusammenhang. Ein System, das die Posterior-Wahrscheinlichkeiten einer Sequenz aufgrund ihrer gesamten Historie vorhersagt, kann für eine optimale Datenkompression verwendet werden (durch Verwendung einer arithmetischen Codierung der Ausgabeverteilung). Ein optimaler Kompressor kann für die Vorhersage verwendet werden (indem das Symbol gefunden wird, das angesichts der Vorgeschichte am besten komprimiert wird). Diese Äquivalenz wurde als Rechtfertigung für die Verwendung der Datenkomprimierung als Maßstab für “allgemeine Intelligenz” verwendet.[17][18][19]

Eine alternative Ansicht kann zeigen, dass Kompressionsalgorithmen Zeichenfolgen implizit in implizite Merkmalsraumvektoren abbilden, und auf Kompression basierende Ähnlichkeitsmaße berechnen Ähnlichkeiten innerhalb dieser Merkmalsräume. Für jeden Kompressor C(.) definieren wir einen zugehörigen Vektorraum ℵ, so dass C(.) einen Eingabestring x abbildet, der der Vektornorm ||~x|| entspricht. Eine erschöpfende Untersuchung der allen Kompressionsalgorithmen zugrunde liegenden Merkmalsräume wird durch den Raum ausgeschlossen; stattdessen entscheidet sich Merkmalsvektoren, drei repräsentative verlustfreie Kompressionsverfahren zu untersuchen, LZW, LZ77 und PPM.[20]

Nach der AIXI-Theorie, einer Verbindung, die im Hutter-Preis direkter erklärt wird, ist die bestmögliche Komprimierung von x die kleinstmögliche Software, die x erzeugt. In diesem Modell umfasst die komprimierte Größe einer ZIP-Datei beispielsweise sowohl die ZIP-Datei als auch die Entpacksoftware, da Sie sie ohne beide nicht entpacken können, es kann jedoch eine noch kleinere kombinierte Form geben.

Datendifferenzierung[edit]

Die Datenkomprimierung kann als Sonderfall der Datendifferenzierung angesehen werden.[21][22] Die Datendifferenzierung besteht darin, a Unterschied angenommen Quelle und ein Ziel, mit Patching zur Wiedergabe der Ziel angenommen Quelle und ein Unterschied. Da es bei der Datenkompression keine getrennte Quelle und Ziel gibt, kann man die Datenkompression als Datendifferenzierung mit leeren Quelldaten betrachten, wobei die komprimierte Datei einem Unterschied von nichts entspricht. Dies entspricht der Betrachtung der absoluten Entropie (entsprechend der Datenkompression) als Spezialfall der relativen Entropie (entsprechend der Datendifferenzierung) ohne Anfangsdaten.

Der Begriff Differenzialkompression wird verwendet, um die datendifferenzierende Verbindung hervorzuheben.

Bild[edit]

Entropiekodierung entstand in den 1940er Jahren mit der Einführung der Shannon-Fano-Kodierung.[23] die Grundlage für die 1950 entwickelte Huffman-Codierung.[24]Die Transformationscodierung geht auf die späten 1960er Jahre zurück, mit der Einführung der Fast-Fourier-Transformation (FFT)-Codierung im Jahr 1968 und der Hadamard-Transformation im Jahr 1969.[25]

Eine wichtige Bildkompressionstechnik ist die diskrete Kosinustransformation (DCT), eine Technik, die in den frühen 1970er Jahren entwickelt wurde.[13] DCT ist die Grundlage für JPEG, ein verlustbehaftetes Kompressionsformat, das 1992 von der Joint Photographic Experts Group (JPEG) eingeführt wurde.[26] JPEG reduziert die zur Darstellung eines Bildes erforderliche Datenmenge erheblich auf Kosten einer relativ geringen Verringerung der Bildqualität und ist das am weitesten verbreitete Bilddateiformat geworden.[27][28] Sein hocheffizienter DCT-basierter Komprimierungsalgorithmus war maßgeblich für die weite Verbreitung digitaler Bilder und digitaler Fotos verantwortlich.[29]

Lempel-Ziv-Welch (LZW) ist ein 1984 entwickelter verlustfreier Komprimierungsalgorithmus. Er wird im 1987 eingeführten GIF-Format verwendet.[30]DEFLATE, ein 1996 spezifizierter verlustfreier Komprimierungsalgorithmus, wird im Portable Network Graphics (PNG)-Format verwendet.[31]

Wavelet-Kompression, die Verwendung von Wavelets bei der Bildkompression, begann nach der Entwicklung der DCT-Codierung.[32] Der JPEG 2000-Standard wurde im Jahr 2000 eingeführt.[33] Im Gegensatz zum DCT-Algorithmus, der vom ursprünglichen JPEG-Format verwendet wird, verwendet JPEG 2000 stattdessen Algorithmen zur diskreten Wavelet-Transformation (DWT).[34][35][36] Die JPEG 2000-Technologie, die die Motion JPEG 2000-Erweiterung enthält, wurde 2004 als Videocodierungsstandard für das digitale Kino ausgewählt.[37]

Audio[edit]

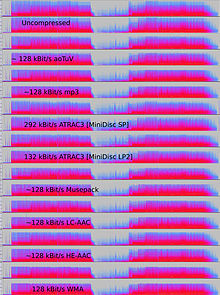

Die Audiodatenkompression, nicht zu verwechseln mit der Dynamikbereichskompression, hat das Potenzial, die Übertragungsbandbreite und den Speicherbedarf von Audiodaten zu reduzieren. Audiokompressionsalgorithmen werden in Software als Audiocodecs implementiert. Sowohl bei der verlustbehafteten als auch bei der verlustfreien Komprimierung wird die Informationsredundanz reduziert, indem Verfahren wie Codierung, Quantisierung, diskrete Kosinustransformation und lineare Vorhersage verwendet werden, um die Informationsmenge zu reduzieren, die zur Darstellung der unkomprimierten Daten verwendet wird.

Verlustbehaftete Audiokompressionsalgorithmen bieten eine höhere Kompression und werden in zahlreichen Audioanwendungen einschließlich Vorbis und MP3 verwendet. Diese Algorithmen beruhen fast alle auf Psychoakustik, um weniger hörbare Geräusche zu eliminieren oder die Wiedergabetreue zu reduzieren, wodurch der Platz verringert wird, der für deren Speicherung oder Übertragung erforderlich ist.[2][38]

Der akzeptable Kompromiss zwischen Audioqualitätsverlust und Übertragungs- oder Speichergröße hängt von der Anwendung ab. Eine 640 MB Compact Disc (CD) enthält beispielsweise ungefähr eine Stunde unkomprimierte HiFi-Musik, weniger als 2 Stunden verlustfrei komprimierte Musik oder 7 Stunden Musik, die im MP3-Format mit einer mittleren Bitrate komprimiert wurde. Ein digitaler Tonrekorder kann in der Regel etwa 200 Stunden klar verständliche Sprache in 640 MB speichern.[39]

Die verlustfreie Audiokompression erzeugt eine Darstellung digitaler Daten, die in ein exaktes digitales Duplikat des Originals dekodiert werden können. Die Kompressionsverhältnisse liegen bei etwa 50–60 % der Originalgröße,[40] die denen für die generische verlustfreie Datenkomprimierung ähnlich ist. Verlustfreie Codecs verwenden eine Kurvenanpassung oder eine lineare Vorhersage als Grundlage für die Schätzung des Signals. Parameter, die die Schätzung und die Differenz zwischen der Schätzung und dem tatsächlichen Signal beschreiben, werden separat codiert.[41]

Es gibt eine Reihe von verlustfreien Audiokompressionsformaten. Eine Auflistung finden Sie in der Liste der verlustfreien Codecs. Einige Formate sind mit einem bestimmten System verbunden, wie z. B. Direct Stream Transfer, das in Super Audio CDs und Meridian Lossless Packing verwendet wird, das in DVD-Audio, Dolby TrueHD, Blu-ray und HD DVD verwendet wird.

Einige Audiodateiformate bieten eine Kombination aus einem verlustbehafteten Format und einer verlustfreien Korrektur; Dies ermöglicht das Entfernen der Korrektur, um leicht eine verlustbehaftete Datei zu erhalten. Zu diesen Formaten gehören MPEG-4 SLS (Scalable to Lossless), WavPack und OptimFROG DualStream.

Wenn Audiodateien bearbeitet werden sollen, sei es durch weitere Komprimierung oder zum Editieren, ist es wünschenswert, von einem unveränderten Original (unkomprimiert oder verlustfrei komprimiert) zu arbeiten. Die Verarbeitung einer verlustreich komprimierten Datei für einen bestimmten Zweck führt normalerweise zu einem Endergebnis, das der Erstellung derselben komprimierten Datei aus einem unkomprimierten Original unterlegen ist. Neben der Tonbearbeitung oder -mischung wird die verlustfreie Audiokomprimierung häufig zur Archivierung oder als Kopiervorlage verwendet.

Verlustbehaftete Audiokomprimierung[edit]

Verlustbehaftete Audiokomprimierung wird in einer Vielzahl von Anwendungen verwendet. Neben eigenständigen reinen Audioanwendungen zur Dateiwiedergabe in MP3-Playern oder Computern werden digital komprimierte Audiostreams in den meisten Video-DVDs, digitalem Fernsehen, Streaming-Medien im Internet, Satelliten- und Kabelradio und zunehmend auch in terrestrischen Radiosendungen verwendet. Die verlustbehaftete Komprimierung erreicht in der Regel eine weitaus höhere Komprimierung als die verlustfreie Komprimierung, indem weniger kritische Daten basierend auf psychoakustischen Optimierungen verworfen werden.[42]

Die Psychoakustik erkennt, dass nicht alle Daten in einem Audiostream vom menschlichen Hörsystem wahrgenommen werden können. Die meisten verlustbehafteten Kompressionen reduzieren die Redundanz, indem zuerst wahrnehmungsrelevante Geräusche identifiziert werden, dh Geräusche, die sehr schwer zu hören sind. Typische Beispiele sind hohe Frequenzen oder Geräusche, die gleichzeitig mit lauteren Geräuschen auftreten. Diese irrelevanten Geräusche werden mit geringerer Genauigkeit oder gar nicht codiert.

Aufgrund der Natur verlustbehafteter Algorithmen erleidet die Audioqualität einen Verlust der digitalen Generation, wenn eine Datei dekomprimiert und erneut komprimiert wird. Dies macht eine verlustbehaftete Komprimierung ungeeignet, um die Zwischenergebnisse in professionellen Audiotechnik-Anwendungen wie Tonbearbeitung und Mehrspuraufnahmen zu speichern. Verlustbehaftete Formate wie MP3 sind jedoch bei Endbenutzern sehr beliebt, da die Dateigröße auf 5-20% der ursprünglichen Größe reduziert wird und ein Megabyte Musik im Wert von etwa einer Minute in angemessener Qualität speichern kann.

Kodierungsmethoden[edit]

Um zu bestimmen, welche Informationen in einem Audiosignal wahrnehmungstechnisch irrelevant sind, verwenden die meisten verlustbehafteten Kompressionsalgorithmen Transformationen wie die modifizierte diskrete Kosinustransformation (MDCT), um im Zeitbereich abgetastete Wellenformen in einen Transformationsbereich, typischerweise den Frequenzbereich, umzuwandeln. Nach der Transformation können Komponentenfrequenzen entsprechend ihrer Hörbarkeit priorisiert werden. Die Hörbarkeit spektraler Komponenten wird anhand der absoluten Hörschwelle und der Prinzipien der simultanen Maskierung bewertet – das Phänomen, bei dem ein Signal durch ein anderes frequenzgetrenntes Signal maskiert wird – und in einigen Fällen die zeitliche Maskierung – bei der ein Signal durch ein anderes Signal maskiert wird zeitlich getrennt. Konturen gleicher Lautstärke können auch verwendet werden, um die wahrnehmungsbezogene Bedeutung von Komponenten zu gewichten. Modelle der menschlichen Ohr-Hirn-Kombination, die solche Effekte beinhalten, werden oft als psychoakustische Modelle bezeichnet.[43]

Andere Arten von verlustbehafteten Komprimierern, wie beispielsweise die bei Sprache verwendete lineare prädiktive Codierung (LPC), sind quellenbasierte Codierer. LPC verwendet ein Modell des menschlichen Stimmtrakts, um Sprachlaute zu analysieren und die Parameter abzuleiten, die vom Modell verwendet werden, um sie von Moment zu Moment zu erzeugen. Diese sich ändernden Parameter werden übertragen oder gespeichert und verwendet, um ein anderes Modell im Decoder anzusteuern, das den Ton reproduziert.

Verlustbehaftete Formate werden häufig für die Verbreitung von Audiostreams oder interaktiver Kommunikation verwendet (z. B. in Mobilfunknetzen). Bei solchen Anwendungen müssen die Daten während des Datenflusses dekomprimiert werden, anstatt nachdem der gesamte Datenstrom übertragen wurde. Nicht alle Audio-Codecs können für Streaming-Anwendungen verwendet werden.[42]

Latenz wird durch die Methoden eingeführt, die zum Kodieren und Dekodieren der Daten verwendet werden. Einige Codecs analysieren ein längeres Segment, genannt a Rahmen, der Daten, um die Effizienz zu optimieren, und dann so zu codieren, dass ein größeres Datensegment gleichzeitig zum Decodieren erforderlich ist. Die inhärente Latenz des Codierungsalgorithmus kann kritisch sein; beispielsweise bei einer Zweiwegeübertragung von Daten, wie beispielsweise bei einem Telefongespräch, können erhebliche Verzögerungen die wahrgenommene Qualität ernsthaft verschlechtern.

Im Gegensatz zur Kompressionsgeschwindigkeit, die proportional zur Anzahl der vom Algorithmus benötigten Operationen ist, bezieht sich die Latenz hier auf die Anzahl der Samples, die analysiert werden müssen, bevor ein Audioblock verarbeitet wird. Im minimalen Fall beträgt die Latenz null Abtastwerte (z. B. wenn der Codierer/Decodierer einfach die Anzahl der zum Quantisieren des Signals verwendeten Bits reduziert). Zeitbereichsalgorithmen wie LPC haben auch oft niedrige Latenzen, daher ihre Popularität bei der Sprachcodierung für die Telefonie. Bei Algorithmen wie MP3 muss jedoch eine große Anzahl von Samples analysiert werden, um ein psychoakustisches Modell im Frequenzbereich zu implementieren, und die Latenz liegt in der Größenordnung von 23 ms.

Sprachcodierung[edit]

Die Sprachcodierung ist eine wichtige Kategorie der Audiodatenkomprimierung. Die Wahrnehmungsmodelle, die verwendet werden, um zu schätzen, welche Aspekte der Sprache ein menschliches Ohr hören kann, unterscheiden sich im Allgemeinen etwas von denen, die für Musik verwendet werden. Der Frequenzbereich, der benötigt wird, um die Klänge einer menschlichen Stimme zu übertragen, ist normalerweise viel enger als der für Musik benötigte, und der Klang ist normalerweise weniger komplex. Als Ergebnis kann Sprache unter Verwendung einer relativ niedrigen Bitrate mit hoher Qualität codiert werden.

Dies wird im Allgemeinen durch eine Kombination von zwei Ansätzen erreicht:

- Es werden nur Geräusche kodiert, die von einer einzigen menschlichen Stimme erzeugt werden könnten.

- Es werden mehr Daten im Signal weggeworfen – gerade genug, um eine “verständliche” Stimme zu rekonstruieren, anstatt den vollen Frequenzbereich des menschlichen Gehörs.

Die frühesten Algorithmen, die bei der Sprachcodierung (und der Audiodatenkompression im Allgemeinen) verwendet wurden, waren der A-Law-Algorithmus und der μ-Law-Algorithmus.

Geschichte[edit]

Frühe Audioforschung wurde in Bell Labs durchgeführt. Dort meldete C. Chapin Cutler 1950 das Patent zur Differenzial-Puls-Code-Modulation (DPCM) an.[44] 1973 wurde Adaptive DPCM (ADPCM) von P. Cummiskey, Nikil S. Jayant und James L. Flanagan eingeführt.[45][46]

Die perzeptuelle Codierung wurde zuerst für die Sprachcodierungskompression mit linearer prädiktiver Codierung (LPC) verwendet.[47] Erste Konzepte für LPC gehen auf die Arbeit von Fumitada Itakura (Nagoya University) und Shuzo Saito (Nippon Telegraph and Telephone) im Jahr 1966 zurück.[48] In den 1970er Jahren entwickelten Bishnu S. Atal und Manfred R. Schroeder von den Bell Labs eine Form der LPC namens adaptive prädiktive Codierung (APC), einen wahrnehmungsbezogenen Codierungsalgorithmus, der die Maskierungseigenschaften des menschlichen Ohrs ausnutzte, gefolgt in den frühen 1980er Jahren mit dem Code-angeregter linearer Prädiktionsalgorithmus (CELP), der für seine Zeit ein signifikantes Kompressionsverhältnis erreichte.[47] Perceptual Coding wird von modernen Audiokompressionsformaten wie MP3 verwendet[47] und AAC.

Diskrete Kosinustransformation (DCT), 1974 von Nasir Ahmed, T. Natarajan und KR Rao entwickelt,[14] lieferte die Grundlage für die modifizierte diskrete Kosinustransformation (MDCT), die von modernen Audiokompressionsformaten wie MP3 verwendet wird,[49]Dolby Digital,[50][51] und AAC.[52] MDCT wurde 1987 von JP Princen, AW Johnson und AB Bradley vorgeschlagen.[53] nach früheren Arbeiten von Princen und Bradley im Jahr 1986.[54]

Das weltweit erste kommerzielle Audiokompressionssystem zur Automatisierung von Rundfunksendungen wurde von Oscar Bonello, einem Ingenieursprofessor an der Universität von Buenos Aires, entwickelt.[55][failed verification] 1983 unter Verwendung des psychoakustischen Prinzips der Maskierung kritischer Bänder, das erstmals 1967 veröffentlicht wurde,[56] er begann mit der Entwicklung einer praktischen Anwendung auf Basis des neu entwickelten IBM PC-Rechners und 1987 wurde das Broadcast-Automatisierungssystem unter dem Namen Audicom auf den Markt gebracht. Zwanzig Jahre später nutzten fast alle Radiosender der Welt ähnliche Technologien, die von einer Reihe von Unternehmen hergestellt wurden.

Ein Literaturkompendium für eine Vielzahl von Audiocodiersystemen wurde in der IEEE veröffentlicht Zeitschrift zu ausgewählten Bereichen der Kommunikation (JSAC).[57]

Video[edit]

Die Videokomprimierung ist eine praktische Implementierung der Quellcodierung in der Informationstheorie. In der Praxis werden die meisten Video-Codecs zusammen mit Audiokompressionstechniken verwendet, um die separaten, aber komplementären Datenströme als ein kombiniertes Paket unter Verwendung sogenannter . zu speichern Containerformate.[58]

Unkomprimiertes Video erfordert eine sehr hohe Datenrate. Obwohl verlustfreie Videokomprimierungscodecs mit einem Komprimierungsfaktor von 5 bis 12 arbeiten, hat ein typisches verlustbehaftetes H.264-Komprimierungsvideo einen Komprimierungsfaktor zwischen 20 und 200.[59]

Die zwei wichtigsten Videokompressionstechniken, die in Videocodierungsstandards verwendet werden, sind die diskrete Kosinustransformation (DCT) und die Bewegungskompensation (MC). Die meisten Videocodierungsstandards, wie beispielsweise die Formate H.26x und MPEG, verwenden typischerweise eine bewegungskompensierte DCT-Videocodierung (Blockbewegungskompensation).[60][61]

Codierungstheorie[edit]

Videodaten können als eine Reihe von Standbildrahmen dargestellt werden. Solche Daten enthalten normalerweise reichliche Mengen an räumlicher und zeitlicher Redundanz. Videokompressionsalgorithmen versuchen, Redundanz zu reduzieren und Informationen kompakter zu speichern.

Die meisten Videokompressionsformate und Codecs nutzen sowohl räumliche als auch zeitliche Redundanz (zB durch Differenzcodierung mit Bewegungskompensation). Ähnlichkeiten können codiert werden, indem nur Unterschiede zwischen zB zeitlich benachbarten Frames (Inter-Frame-Codierung) oder räumlich benachbarten Pixeln (Intra-Frame-Codierung) gespeichert werden. Inter-Frame-Kompression (eine zeitliche Delta-Codierung) verwendet (wieder) Daten von einem oder mehreren früheren oder späteren Frames in einer Sequenz, um den aktuellen Frame zu beschreiben. Andererseits verwendet die Intra-Frame-Codierung nur Daten aus dem aktuellen Frame, was effektiv eine Standbildkompression ist.[43]

Die in Camcordern und der Videobearbeitung verwendeten Intra-Frame-Videocodierungsformate verwenden eine einfachere Komprimierung, die nur die Intra-Frame-Vorhersage verwendet. Dies vereinfacht die Videobearbeitungssoftware, da es verhindert, dass ein P- oder B-Frame auf Daten verweist, die der Editor gelöscht hat.

Üblicherweise werden bei der Videokompression zusätzlich verlustbehaftete Kompressionstechniken wie Quantisierung verwendet, die Aspekte der Quelldaten reduzieren, die (mehr oder weniger) für die menschliche visuelle Wahrnehmung irrelevant sind, indem Wahrnehmungsmerkmale des menschlichen Sehens ausgenutzt werden. Kleine Farbunterschiede sind beispielsweise schwieriger wahrzunehmen als Helligkeitsänderungen. Komprimierungsalgorithmen können eine Farbe über diese ähnlichen Bereiche mitteln, um den Raum zu reduzieren, ähnlich wie bei der JPEG-Bildkomprimierung.[9] Wie bei jeder verlustbehafteten Komprimierung gibt es einen Kompromiss zwischen Videoqualität und Bitrate, Kosten für die Verarbeitung der Komprimierung und Dekomprimierung und Systemanforderungen. Stark komprimiertes Video kann sichtbare oder ablenkende Artefakte aufweisen.

Andere Methoden als die vorherrschenden DCT-basierten Transformationsformate, wie z Verwendung von Wavelet-Codierung als Standbildcodierer ohne Bewegungskompensation). Das Interesse an fraktaler Kompression scheint zu schwinden, da neuere theoretische Analysen einen vergleichsweise geringen Wirkungsgrad solcher Methoden zeigen.[43]

Inter-Frame-Codierung[edit]

Die Inter-Frame-Codierung funktioniert durch den Vergleich jedes Frames im Video mit dem vorherigen. Einzelne Frames einer Videosequenz werden von einem Frame zum nächsten verglichen und der Videokompressionscodec sendet nur die Unterschiede an den Referenzframe. Wenn der Rahmen Bereiche enthält, in denen sich nichts bewegt hat, kann das System einfach einen kurzen Befehl ausgeben, der diesen Teil des vorherigen Rahmens in den nächsten kopiert. Wenn sich Teile des Bildes auf einfache Weise bewegen, kann der Kompressor einen (etwas längeren) Befehl ausgeben, der den Dekompressor anweist, die Kopie zu verschieben, zu drehen, aufzuhellen oder abzudunkeln. Dieser längere Befehl bleibt immer noch viel kürzer als die Intraframe-Komprimierung. Normalerweise überträgt der Codierer auch ein Restsignal, das die verbleibenden feineren Unterschiede zu den Referenzbildern beschreibt. Unter Verwendung der Entropiecodierung haben diese Restsignale eine kompaktere Darstellung als das vollständige Signal. In Videobereichen mit mehr Bewegung muss die Komprimierung mehr Daten codieren, um mit der größeren Anzahl von Pixeln Schritt zu halten, die sich ändern. Häufig führen die hochfrequenten Details bei Explosionen, Flammen, Tierschwärmen und bei einigen Kameraschwenks zu Qualitätseinbußen oder zu einer Erhöhung der variablen Bitrate.

Hybride blockbasierte Transformationsformate[edit]

Heutzutage teilen fast alle gebräuchlichen Videokompressionsverfahren (zB diejenigen in Standards, die von der ITU-T oder ISO genehmigt wurden) dieselbe grundlegende Architektur, die auf H.261 zurückgeht und 1988 von der ITU-T standardisiert wurde. Sie beruhen hauptsächlich auf der DCT, die auf rechteckige Blöcke benachbarter Pixel angewendet wird, und der zeitlichen Vorhersage unter Verwendung von Bewegungsvektoren sowie heutzutage auch auf einem In-Loop-Filterschritt.

In der Vorhersagephase werden verschiedene Deduplizierungs- und Differenzcodierungstechniken angewendet, die helfen, Daten zu dekorrelieren und neue Daten basierend auf bereits übertragenen Daten zu beschreiben.

Dann werden rechteckige Blöcke von (Rest-)Pixeldaten in den Frequenzbereich transformiert, um das Zielen auf irrelevante Informationen bei der Quantisierung und für eine gewisse Reduzierung der räumlichen Redundanz zu erleichtern. Die in diesem Zusammenhang weit verbreitete diskrete Kosinustransformation (DCT) wurde 1974 von N. Ahmed, T. Natarajan und KR Rao eingeführt.[14]

In der verlustbehafteten Hauptverarbeitungsphase werden diese Daten quantisiert, um Informationen zu reduzieren, die für die menschliche visuelle Wahrnehmung irrelevant sind.

In der letzten Stufe wird die statistische Redundanz weitgehend durch einen Entropiecodierer eliminiert, der oft irgendeine Form der arithmetischen Codierung anwendet.

In einer zusätzlichen In-Loop-Filterstufe können verschiedene Filter auf das rekonstruierte Bildsignal angewendet werden. Durch die Berechnung dieser Filter auch innerhalb der Codierschleife können sie die Komprimierung unterstützen, da sie auf Referenzmaterial angewendet werden können, bevor es im Vorhersageprozess verwendet wird, und sie können unter Verwendung des Originalsignals geführt werden. Das beliebteste Beispiel sind Deblocking-Filter, die Blocking-Artefakte aus Quantisierungsdiskontinuitäten an Transformationsblockgrenzen verwischen.

Geschichte[edit]

1967 schlugen AH Robinson und C. Cherry ein Bandbreitenkompressionsschema zur Lauflängencodierung für die Übertragung analoger Fernsehsignale vor.[62]Diskrete Kosinustransformation (DCT), die für die moderne Videokompression grundlegend ist,[63] wurde 1974 von Nasir Ahmed, T. Natarajan und KR Rao eingeführt.[14][64]

H.261, das 1988 debütierte, führte die vorherrschende grundlegende Architektur der Videokompressionstechnologie kommerziell ein.[65] Es war das erste auf DCT-Komprimierung basierende Videocodierungsformat, das später zum Standard für alle folgenden wichtigen Videocodierungsformate wurde.[63] H.261 wurde von einer Reihe von Unternehmen entwickelt, darunter Hitachi, PictureTel, NTT, BT und Toshiba.[66]

Die beliebtesten Videocodierungsstandards für Codecs waren die MPEG-Standards. MPEG-1 wurde 1991 von der Motion Picture Experts Group (MPEG) entwickelt und wurde entwickelt, um Videos in VHS-Qualität zu komprimieren. Es wurde 1994 von MPEG-2/H.262 abgelöst,[65] die von einer Reihe von Unternehmen entwickelt wurde, hauptsächlich Sony, Thomson und Mitsubishi Electric.[67] MPEG-2 wurde zum Standard-Videoformat für das digitale DVD- und SD-Fernsehen.[65] 1999 folgte MPEG-4/H.263, was einen großen Sprung nach vorn für die Videokompressionstechnologie darstellte.[65] Es wurde von einer Reihe von Unternehmen entwickelt, hauptsächlich Mitsubishi Electric, Hitachi und Panasonic.[68]

Das am weitesten verbreitete Videocodierungsformat ist H.264/MPEG-4 AVC. Es wurde 2003 von einer Reihe von Organisationen entwickelt, hauptsächlich Panasonic, Godo Kaisha IP Bridge und LG Electronics.[69] AVC führte die moderne kontextadaptive binäre arithmetische Codierung (CABAC) und die kontextadaptive Variable-Length-Codierung (CAVLC) kommerziell ein. AVC ist der wichtigste Videocodierungsstandard für Blu-ray-Discs und wird häufig von Video-Sharing-Websites und Streaming-Internetdiensten wie YouTube, Netflix, Vimeo und iTunes Store, Websoftware wie Adobe Flash Player und Microsoft Silverlight und verschiedenen verwendet HDTV-Sendungen über terrestrisches und Satellitenfernsehen.

Genetik[edit]

Genetische Kompressionsalgorithmen sind die neueste Generation von verlustfreien Algorithmen, die Daten (typischerweise Sequenzen von Nukleotiden) komprimieren, wobei sowohl konventionelle Kompressionsalgorithmen als auch genetische Algorithmen verwendet werden, die an den spezifischen Datentyp angepasst sind. Im Jahr 2012 veröffentlichte ein Team von Wissenschaftlern der Johns Hopkins University einen genetischen Kompressionsalgorithmus, der kein Referenzgenom für die Kompression verwendet. HAPZIPPER wurde auf HapMap-Daten zugeschnitten und erreicht eine über 20-fache Komprimierung (95% Reduzierung der Dateigröße) und bietet eine 2- bis 4-fach bessere Komprimierung und in viel schnellerer Zeit als die führenden universellen Komprimierungsprogramme. Dazu führten Chanda, Elhaik und Bader MAF-basierte Kodierung (MAFE) ein, die die Heterogenität des Datensatzes reduziert, indem sie SNPs nach ihrer Nebenallelfrequenz sortiert und so den Datensatz homogenisiert.[70] Andere Algorithmen in den Jahren 2009 und 2013 (DNAZip und GenomeZip) haben Komprimierungsraten von bis zu 1200-fach, was die Speicherung von 6 Milliarden Basenpaaren diploiden menschlichen Genomen in 2,5 Megabyte (relativ zu einem Referenzgenom oder gemittelt über viele Genome) ermöglicht.[71][72] Einen Benchmark für Genetik-/Genomik-Datenkompressoren finden Sie unter [73]

Ausblick und derzeit ungenutztes Potenzial[edit]

Es wird geschätzt, dass die Gesamtdatenmenge, die auf den Speichergeräten der Welt gespeichert ist, mit bestehenden Komprimierungsalgorithmen um einen verbleibenden durchschnittlichen Faktor von 4,5:1 weiter komprimiert werden könnte.[74] Es wird geschätzt, dass die kombinierte technologische Kapazität der Welt zum Speichern von Informationen im Jahr 2007 1.300 Exabyte an Hardware-Ziffern bereitstellt, aber wenn der entsprechende Inhalt optimal komprimiert ist, entspricht dies nur 295 Exabyte an Shannon-Informationen.[75]

Siehe auch[edit]

Verweise[edit]

- ^ Wade, Graham (1994). Signalcodierung und -verarbeitung (2 Hrsg.). Cambridge University Press. P. 34. ISBN 978-0-521-42336-6. Abgerufen 2011-12-22.

Das allgemeine Ziel der Quellcodierung besteht darin, „ineffiziente“ Redundanz in der PCM-Quelle auszunutzen oder zu beseitigen und dadurch eine Reduzierung der Gesamtquellrate R zu erreichen.

- ^ ein B Mahdi, OA; Mohammed, MA; Mohamed, AJ (November 2012). “Implementieren eines neuartigen Ansatzes und Konvertieren von Audiokomprimierung in Textcodierung mittels Hybridtechnik” (PDF). Internationale Zeitschrift für Informatikfragen. 9 (6, Nr. 3): 53–59. Abgerufen 6. März 2013.

- ^ Pujar, JH; Kadlaskar, LM (Mai 2010). “Eine neue verlustfreie Methode der Bildkompression und -dekomprimierung unter Verwendung von Huffman-Codierungstechniken” (PDF). Zeitschrift für Theoretische und Angewandte Informationstechnologie. fünfzehn (1): 18–23.

- ^ Salomon, David (2008). Eine kurze Einführung in die Datenkomprimierung. Berlin: Springer. ISBN 9781848000728.

- ^ Panzer, MK (2011). „Implementierung des Lempel-ZIV-Algorithmus zur verlustfreien Komprimierung mit VHDL“. Implementierung des Limpel-Ziv-Algorithmus zur verlustfreien Komprimierung mit VHDL. Thinkquest 2010: Proceedings of the First International Conference on Contours of Computing Technology. Berlin: Springer. S. 275–283. mach:10.1007/978-81-8489-989-4_51. ISBN 978-81-8489-988-7.

- ^ Navqi, Saud; Naqvi, R.; Riaz, RA; Siddiqui, F. (April 2011). “Optimiertes RTL-Design und Implementierung des LZW-Algorithmus für Anwendungen mit hoher Bandbreite” (PDF). Elektrische Überprüfung. 2011 (4): 279–285.

- ^ Stephen, Wolfram (2002). Neue Art der Wissenschaft. Champaign, IL. P. 1069. ISBN 1-57955-008-8.

- ^ ein B Mahmud, Salauddin (März 2012). “Eine verbesserte Datenkomprimierungsmethode für allgemeine Daten” (PDF). Internationale Zeitschrift für wissenschaftliche und technische Forschung. 3 (3): 2. Abgerufen 6. März 2013.

- ^ ein B Lane, Tom. “FAQ zur JPEG-Bildkomprimierung, Teil 1”. Internet-FAQ-Archive. Unabhängige JPEG-Gruppe. Abgerufen 6. März 2013.

- ^ GJ Sullivan; J.-R. Ohm; W J. Han; T. Wiegand (Dezember 2012). “Übersicht über den High Efficiency Video Coding (HEVC) Standard”. IEEE Transactions on Circuits and Systems for Video Technology. IEEE. 22 (12): 1649–1668. mach:10.1109/TCSVT.2012.2221191.

- ^ Wolfram, Stephen (2002). Eine neue Art der Wissenschaft. Wolfram Media, Inc. p. 1069. ISBN 978-1-57955-008-0.

- ^ Erzengel, Cory. “Auf Komprimierung” (PDF). Abgerufen 6. März 2013.

- ^ ein B Ahmed, Nasir (Januar 1991). „Wie ich auf die diskrete Kosinustransformation kam“. Digitale Signalverarbeitung. 1 (1): 4–5. mach:10.1016/1051-2004(91)90086-Z.

- ^ ein B C D Nasir Ahmed; T. Natarajan; Kamisetty Ramamohan Rao (Januar 1974). “Diskrete Kosinustransformation” (PDF). IEEE-Transaktionen auf Computern. C-23 (1): 90–93. mach:10.1109/TC.1974.223784.

- ^ CCITT Study Group VIII und die Joint Photographic Experts Group (JPEG) von ISO/IEC Joint Technical Committee 1/Subcommittee 29/Working Group 10 (1993), „Annex D – Arithmetic Coding“, Empfehlung T.81: Digitale Komprimierung und Codierung von Halbton-Standbildern – Anforderungen und Richtlinien (PDF), S. 54 ff, abgerufen 2009-11-07

- ^ Marak, Laszlo. “Über die Bildkomprimierung” (PDF). Universität Marne la Vallée. Archiviert von das Original (PDF) am 28. Mai 2015. Abgerufen 6. März 2013.

- ^ Mahoney, Matt. “Grundlage für einen großen Textkomprimierungs-Benchmark”. Florida Institute of Technology. Abgerufen 5. März 2013.

- ^ Schmilovici A.; Kahiri Y.; Ben-Gal. I.; Hauser S. (2009). “Messung der Effizienz des Intraday-Forex-Marktes mit einem universellen Datenkomprimierungsalgorithmus” (PDF). Computational Economics. 33 (2): 131–154. CiteSeerX 10.1.1.627.3751. mach:10.1007/s10614-008-9153-3. S2CID 17234503.

- ^ I. Ben-Gal (2008). “Über die Verwendung von Datenkomprimierungsmaßnahmen zur Analyse robuster Designs” (PDF). IEEE-Transaktionen zur Zuverlässigkeit. 54 (3): 381–388. mach:10.1109/TR.2005.853280. S2CID 9376086.

- ^ D. Scully; Carla E. Brodley (2006). „Kompression und maschinelles Lernen: Eine neue Perspektive auf Merkmalsraumvektoren“. Datenkomprimierungskonferenz, 2006: 332. doi:10.1109/DCC.2006.13. ISBN 0-7695-2545-8. S2CID 12311412.

- ^ Korn, D.; et al. “RFC 3284: Das generische VCDIFF-Differenzierungs- und Komprimierungsdatenformat”. Internettechnik-Arbeitsgruppe. Abgerufen 5. März 2013.

- ^ Korn, GD; Vo, KP (1995). B. Krishnamurthy (Hrsg.). Vdelta: Differenzierung und Kompression. Praktische wiederverwendbare Unix-Software. New York: John Wiley & Sons, Inc.

- ^ Claude Elwood Shannon (1948). Alcatel-Lucent (Hrsg.). “Eine mathematische Theorie der Kommunikation” (PDF). Bell System Fachzeitschrift. 27 (3–4): 379–423, 623–656. mach:10.1002/j.1538-7305.1948.tb01338.x. hdl:11858/00-001M-0000-002C-4314-2. Abgerufen 2019-04-21.

- ^ David Albert Huffman (September 1952), “Eine Methode zur Konstruktion von Codes mit minimaler Redundanz” (PDF), Verfahren des IRE, 40 (9), S. 1098–1101, doi:10.1109/JRPROC.1952.273898

- ^ Pratt, WK; Kane, J.; Andrews, HC (1969). “Hadamard-Transformationsbildcodierung”. Verfahren des IEEE. 57: 58–68. mach:10.1109/PROC.1969.6869.

- ^ “T.81 – DIGITALE KOMPRESSION UND KODIERUNG VON STANDBILDBILDERN – ANFORDERUNGEN UND RICHTLINIEN” (PDF). CCITT. September 1992. Abgerufen 12. Juli 2019.

- ^ “Das JPEG-Bildformat erklärt”. BT.com. BT-Gruppe. 31. Mai 2018. Abgerufen 5. August 2019.

- ^ Baraniuk, Chris (15. Oktober 2015). “Kopierschutz könnte auf JPEGs kommen”. BBC News. BBC. Abgerufen 13. September 2019.

- ^ “Was ist ein JPEG? Das unsichtbare Objekt, das Sie jeden Tag sehen”. Der Atlantik. 24. September 2013. Abgerufen 13. September 2019.

- ^ “Die GIF-Kontroverse: Die Perspektive eines Softwareentwicklers”. Abgerufen 26. Mai 2015.

- ^ L. Peter Deutsch (Mai 1996). DEFLATE Komprimierte Datenformatspezifikation Version 1.3. IETF. P. 1 Sek. Abstrakt. mach:10.17487/RFC1951. RFC 1951. Abgerufen 2014-04-23.

- ^ Hoffmann, Roy (2012). Datenkomprimierung in digitalen Systemen. Springer Wissenschaft & Wirtschaftsmedien. P. 124. ISBN 9781461560319.

Grundsätzlich ist die Wavelet-Codierung eine Variante der DCT-basierten Transformationscodierung, die einige ihrer Einschränkungen reduziert oder beseitigt. (…) Ein weiterer Vorteil besteht darin, dass die Wavelet-Codierung, anstatt mit 8 × 8 Pixelblöcken zu arbeiten, wie JPEG und andere blockbasierte DCT-Techniken, das gesamte Bild gleichzeitig komprimieren kann.

- ^ Taubman, David; Marzellin, Michael (2012). Grundlagen, Standards und Praxis der JPEG2000-Bildkomprimierung: Grundlagen, Standards und Praxis der Bildkomprimierung. Springer Wissenschaft & Wirtschaftsmedien. ISBN 9781461507994.

- ^ Unser, M.; Blu, T. (2003). “Mathematische Eigenschaften der JPEG2000-Wavelet-Filter”. IEEE-Transaktionen zur Bildverarbeitung. 12 (9): 1080–1090. Bibcode:2003ITIP…12.1080U. mach:10.1109/TIP.2003.812329. PMID 18237979. S2CID 2765169.

- ^ Sullivan, Gary (8.–12. Dezember 2003). “Allgemeine Eigenschaften und Designüberlegungen für die zeitliche Subband-Videocodierung”. ITU-T. Expertengruppe für Videocodierung. Abgerufen 13. September 2019.

- ^ Bovik, Alan C. (2009). Der grundlegende Leitfaden zur Videoverarbeitung. Akademische Presse. P. 355. ISBN 9780080922508.

- ^ Swartz, Charles S. (2005). Das digitale Kino verstehen: Ein professionelles Handbuch. Taylor & Franz. P. 147. ISBN 9780240806174.

- ^ Cunningham, Stuart; McGregor, Iain (2019). “Subjektive Bewertung von mit dem ACER-Codec komprimierter Musik im Vergleich zu AAC, MP3 und unkomprimiertem PCM”. Internationale Zeitschrift für digitalen Multimedia-Rundfunk. 2019: 1–16. mach:10.1155/2019/8265301.

- ^ Der digitale Sprachrekorder Olympus WS-120 kann laut Handbuch etwa 178 Stunden Audio in Sprachqualität im .WMA-Format in 500 MB Flash-Speicher speichern.

- ^ Kohlen, Josh. “FLAC-Vergleich”. Abgerufen 2020-08-23.

- ^ “Formatübersicht”. Abgerufen 2020-08-23.

- ^ ein B Jaiswal, RC (2009). Audio-Video-Engineering. Pune, Maharashtra: Nirali Prakashan. P. 3.41. ISBN 9788190639675.

- ^ ein B C Faxin Yu; Hao Luo; Zheming Lu (2010). Dreidimensionale Modellanalyse und -verarbeitung. Berlin: Springer. P. 47. ISBN 9783642126512.

- ^ US-Patent 2605361, C. Chapin Cutler, “Differential Quantization of Communication Signals”, herausgegeben 1952-07-29

- ^ Cummiskey, P.; Jayant, NS; Flanagan, JL (1973). „Adaptive Quantisierung in der differentiellen PCM-Codierung von Sprache“. Bell System Fachzeitschrift. 52 (7): 1105–1118. mach:10.1002/j.1538-7305.1973.tb02007.x.

- ^ Cummiskey, P.; Jayant, Nikil S.; Flanagan, JL (1973). „Adaptive Quantisierung in der differentiellen PCM-Codierung von Sprache“. Die Bell System Fachzeitschrift. 52 (7): 1105–1118. mach:10.1002/j.1538-7305.1973.tb02007.x. ISSN 0005-8580.

- ^ ein B C Schröder, Manfred R. (2014). “Glockenlabore”. Akustik, Information und Kommunikation: Gedenkband zu Ehren von Manfred R. Schroeder. Springer. P. 388. ISBN 9783319056609.

- ^ Grau, Robert M. (2010). “Eine Geschichte der digitalen Echtzeitsprache in Paketnetzwerken: Teil II der linearen Vorhersagecodierung und des Internetprotokolls” (PDF). Gefunden. Trends Signalprozess. 3 (4): 203–303. mach:10.1561/2000000036. ISSN 1932-8346.

- ^ Guckert, John (Frühjahr 2012). “Die Verwendung von FFT und MDCT bei der MP3-Audiokomprimierung” (PDF). Universität von Utah. Abgerufen 14. Juli 2019.

- ^ Luo, Fa-Long (2008). Mobile Multimedia Broadcasting Standards: Technologie und Praxis. Springer Wissenschaft & Wirtschaftsmedien. P. 590. ISBN 9780387782638.

- ^ Britanak, V. (2011). “Über Eigenschaften, Beziehungen und vereinfachte Implementierung von Filterbänken in den Dolby Digital (Plus) AC-3 Audio Coding Standards”. IEEE-Transaktionen zur Audio-, Sprach- und Sprachverarbeitung. 19 (5): 1231–1241. mach:10.1109/TASL.2010.2087755. S2CID 897622.

- ^ Brandenburg, Karlheinz (1999). “MP3 und AAC erklärt” (PDF). Archiviert (PDF) vom Original vom 13.02.2017.

- ^ Princen, J.; Johnson, A.; Bradley, A. (1987). “Teilband-/Transformationscodierung unter Verwendung von Filterbankdesigns basierend auf Zeitbereichs-Aliasing-Aufhebung”. ICASSP ’87. Internationale IEEE-Konferenz für Akustik, Sprache und Signalverarbeitung. 12. S. 2161–2164. mach:10.1109/ICASSP.1987.1169405. S2CID 58446992.

- ^ Princen, J.; Bradley, A. (1986). „Analyse/Synthese-Filterbankdesign basierend auf Zeitbereichs-Aliasing-Aufhebung“. IEEE-Transaktionen zu Akustik, Sprache und Signalverarbeitung. 34 (5): 1153-1161. mach:10.1109/TASSP.1986.1164954.

- ^ „Zusammenfassung einiger Beiträge von Solidyne zur Rundfunktechnik“. Kurze Geschichte von Solidyne. Buenos Aires: Solidyne. Archiviert von das Original am 8. März 2013. Abgerufen 6. März 2013.[self-published source?]

- ^ Zwicker, Eberhard; et al. (1967). Das Ohr als Kommunikationsempfänger. Melville, NY: Akustische Gesellschaft von Amerika. Archiviert von das Original am 2000-09-14. Abgerufen 2011-11-11.

- ^ “Möglichkeiten der Dateikomprimierung”. Eine kurze Anleitung zum Komprimieren einer Datei auf 4 verschiedene Arten.

- ^ “Videocodierung”. CSIP-Website. Zentrum für Signal- und Informationsverarbeitung, Georgia Institute of Technology. Archiviert von das Original am 23. Mai 2013. Abgerufen 6. März 2013.

- ^ Dmitriy Watolin; et al. (Graphics & Media Lab Video Group) (März 2007). Verlustfreier Videocodec-Vergleich ‘2007 (PDF) (Prüfbericht). Moskauer Staatsuniversität.

- ^ Chen, Jie; Koc, Ut-Va; Liu, KJ Ray (2001). Design digitaler Videocodiersysteme: Ein vollständiger Ansatz für komprimierte Domänen. CRC-Presse. P. 71. ISBN 9780203904183.

- ^ Li, Jian Ping (2006). Proceedings of the International Computer Conference 2006 on Wavelet Active Media Technology and Information Processing: Chongqing, China, 29.-31. August 2006. Weltwissenschaft. P. 847. ISBN 9789812709998.

- ^ Robinson, AH; Cherry, C. (1967). „Ergebnisse eines Prototyp-Fernsehbandbreiten-Kompressionsschemas“. Verfahren des IEEE. IEEE. 55 (3): 356–364. mach:10.1109/PROC.1967.5493.

- ^ ein B Ghanbari, Mohammed (2003). Standard-Codecs: Bildkomprimierung zu erweiterter Videocodierung. Institut für Technik und Technologie. S. 1–2. ISBN 9780852967102.

- ^ Leser, Cliff (2016-08-31). “Patentlandschaft für lizenzfreie Videocodierung”. In Tescher, Andrew G (Hrsg.). Anwendungen der digitalen Bildverarbeitung XXXIX. 9971. San Diego, Kalifornien: Gesellschaft für Ingenieure von photooptischen Instrumenten. S. 99711B. Bibcode:2016SPIE.9971E..1BR. mach:10.1117/12.2239493. Vorlesungsaufzeichnung, ab 3:05:10.

- ^ ein B C D “Infografik zur Geschichte der Videodateiformate — RealPlayer”. 22. April 2012.

- ^ “Patenterklärungserklärung registriert als H261-07”. ITU. Abgerufen 11. Juli 2019.

- ^ “MPEG-2 Patentliste” (PDF). MPEG LA. Abgerufen 7. Juli 2019.

- ^ “MPEG-4 Visual – Patentliste” (PDF). MPEG LA. Abgerufen 6. Juli 2019.

- ^ “AVC/H.264 – Patentliste” (PDF). MPEG LA. Abgerufen 6. Juli 2019.

- ^ Chanda P, Bader JS, Elhaik E (27. Juli 2012). “HapZipper: Das Teilen von HapMap-Populationen ist jetzt noch einfacher”. Nukleinsäureforschung. 40 (20): e159. mach:10.1093/nar/gks709. PMC 3488212. PMID 22844100.

- ^ Christley S, Lu Y, Li C, Xie X (15. Januar 2009). “Menschliche Genome als E-Mail-Anhänge”. Bioinformatik. 25 (2): 274–5. mach:10.1093/Bioinformatik/btn582. PMID 18996942.

- ^ Pavlichin DS, Weissman T, Yona G (September 2013). “Das menschliche Genom zieht sich wieder zusammen”. Bioinformatik. 29 (17): 2199–202. mach:10.1093/Bioinformatik/btt362. PMID 23793748.

- ^ Hosseini, Morteza; Pratas, Diogo; Pinho, Armando (2016). “Eine Umfrage zu Datenkomprimierungsmethoden für biologische Sequenzen”. Information. 7 (4): 56. doi:10.3390/info7040056.

- ^ “Datenkomprimierung durch logische Synthese” (PDF).

- ^ Hilbert, Martin; López, Priscila (1. April 2011). „Die technologische Kapazität der Welt zum Speichern, Kommunizieren und Berechnen von Informationen“. Wissenschaft. 332 (6025): 60–65. Bibcode:2011Sc…332…60H. mach:10.1126/science.1200970. PMID 21310967. S2CID 206531385.

Externe Links[edit]

Recent Comments