Kanalkapazität – Wikipedia

KanalkapazitätIn der Elektrotechnik, Informatik und Informationstheorie ist dies die enge Obergrenze für die Geschwindigkeit, mit der Informationen zuverlässig über einen Kommunikationskanal übertragen werden können.

Gemäß den Bestimmungen des Satzmodells für verrauschte Kanäle ist die Kanalkapazität eines bestimmten Kanals die höchste Informationsrate (in Informationseinheiten pro Zeiteinheit), die mit einer beliebig kleinen Fehlerwahrscheinlichkeit erreicht werden kann. [1][2]

Die 1948 von Claude E. Shannon entwickelte Informationstheorie definiert den Begriff der Kanalkapazität und liefert ein mathematisches Modell, mit dem man sie berechnen kann. Das Hauptergebnis besagt, dass die Kapazität des Kanals, wie oben definiert, durch das Maximum der gegenseitigen Information zwischen dem Eingang und dem Ausgang des Kanals gegeben ist, wobei die Maximierung in Bezug auf die Eingangsverteilung erfolgt. [3]

Der Begriff der Kanalkapazität war von zentraler Bedeutung für die Entwicklung moderner drahtgebundener und drahtloser Kommunikationssysteme. Mit dem Aufkommen neuartiger Fehlerkorrekturcodierungsmechanismen wurde eine Leistung erzielt, die sehr nahe an den durch die Kanalkapazität versprochenen Grenzen liegt.

Formale Definition[edit]

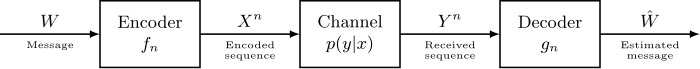

Das grundlegende mathematische Modell für ein Kommunikationssystem ist das folgende:

wo:

Lassen

und

als Zufallsvariablen modelliert werden. Weiterhin lassen

sei die bedingte Wahrscheinlichkeitsverteilungsfunktion von

gegeben

Dies ist eine inhärente feste Eigenschaft des Kommunikationskanals. Dann die Wahl der Randverteilung

bestimmt die gemeinsame Verteilung vollständig

aufgrund der Identität

was wiederum eine gegenseitige Information induziert

. Das Kanalkapazität ist definiert als

wo das Supremum alle möglichen Entscheidungen von übernommen wird

.

Additivität der Kanalkapazität[edit]

Die Kanalkapazität addiert sich gegenüber unabhängigen Kanälen.[4] Dies bedeutet, dass die kombinierte Verwendung von zwei unabhängigen Kanälen die gleiche theoretische Kapazität bietet wie die unabhängige Verwendung. Formeller, lassen Sie

und

zwei unabhängige Kanäle sein, die wie oben modelliert sind;

mit einem Eingabealphabet

und ein Ausgabealphabet

. Idem für

. Wir definieren den Produktkanal

wie

Dieser Satz besagt:

Das zeigen wir zuerst

.

Lassen

und

zwei unabhängige Zufallsvariablen sein. Lassen

eine Zufallsvariable sein, die der Ausgabe von entspricht

durch den Kanal

, und

zum

durch

.

Per Definition

.

Schon seit

und

sind unabhängig, sowie

und

,

ist unabhängig von

. Wir können die folgende Eigenschaft der gegenseitigen Information anwenden:

Im Moment müssen wir nur eine Distribution finden

so dass

. Eigentlich,

und

zwei Wahrscheinlichkeitsverteilungen für

und

erreichen

und

, genügen:

dh.

Lassen Sie uns das jetzt zeigen

.

Lassen

eine Verteilung für den Kanal sein

definieren

und die entsprechende Ausgabe

. Lassen

sei das Alphabet von

,

zum

und analog

und

.

Per Definition der gegenseitigen Information haben wir

Schreiben wir den letzten Begriff der Entropie neu.

Per Definition des Produktkanals,

. Für ein bestimmtes Paar

können wir umschreiben

wie:

Indem wir diese Gleichheit über alle summieren

, wir erhalten

.

Wir können jetzt eine Obergrenze für gegenseitige Informationen festlegen:

Diese Beziehung bleibt im Supremum erhalten. Deshalb

Wenn wir die beiden von uns bewiesenen Ungleichungen kombinieren, erhalten wir das Ergebnis des Satzes:

Shannon-Kapazität eines Graphen[edit]

Wenn G Ist ein ungerichteter Graph, kann er verwendet werden, um einen Kommunikationskanal zu definieren, in dem die Symbole die Eckpunkte des Graphen sind, und zwei Codewörter können miteinander verwechselt werden, wenn ihre Symbole an jeder Position gleich oder benachbart sind. Die rechnerische Komplexität beim Finden der Shannon-Kapazität eines solchen Kanals bleibt offen, kann jedoch durch eine andere wichtige Graphinvariante, die Lovász-Zahl, begrenzt werden.[5]

Noisy-Channel-Codierungssatz[edit]

Der Noisy-Channel-Codierungssatz besagt, dass für jede Fehlerwahrscheinlichkeit ε> 0 und für jede Übertragungsrate gilt R. weniger als die Kanalkapazität C.gibt es ein Codierungs- und Decodierungsschema, das Daten mit einer Rate überträgt R. deren Fehlerwahrscheinlichkeit kleiner als ε ist, für eine ausreichend große Blocklänge. Für jede Rate, die größer als die Kanalkapazität ist, geht die Fehlerwahrscheinlichkeit am Empfänger auf 0,5, wenn die Blocklänge auf unendlich geht.

Beispielanwendung[edit]

Eine Anwendung des Kanalkapazitätskonzepts auf einen additiven weißen Gaußschen Rauschkanal (AWGN) mit B. Hz-Bandbreite und Signal-Rausch-Verhältnis S / N. ist der Shannon-Hartley-Satz:

C. wird in Bit pro Sekunde gemessen, wenn der Logarithmus in Basis 2 genommen wird, oder in Nats pro Sekunde, wenn der natürliche Logarithmus verwendet wird, vorausgesetzt B. ist in Hertz; die Signal- und Rauschleistungen S. und N. werden in einem linearen Netzteil (wie Watt oder Volt) ausgedrückt2). Schon seit S / N. Zahlen werden oft in dB angegeben, eine Umrechnung kann erforderlich sein. Beispielsweise entspricht ein Signal-Rausch-Verhältnis von 30 dB einem linearen Leistungsverhältnis von

.

Kanalkapazität in der drahtlosen Kommunikation[edit]

Diese Abteilung[6] konzentriert sich auf das Einzelantennen-Punkt-zu-Punkt-Szenario. Informationen zur Kanalkapazität in Systemen mit mehreren Antennen finden Sie im Artikel zu MIMO.

Bandbegrenzter AWGN-Kanal[edit]

Wenn die durchschnittliche Empfangsleistung ist

[W]beträgt die Gesamtbandbreite

in Hertz, und die Rauschleistungsspektraldichte ist

[W/Hz]beträgt die AWGN-Kanalkapazität

- [bits/s],

wo

ist das empfangene Signal-Rausch-Verhältnis (SNR). Dieses Ergebnis ist als bekannt Shannon-Hartley-Theorem.[7]

Wenn das SNR groß ist (SNR >> 0 dB), ist die Kapazität

ist logarithmisch in der Leistung und ungefähr linear in der Bandbreite. Dies nennt man das bandbreitenbegrenztes Regime.

Wenn das SNR klein ist (SNR << 0 dB), ist die Kapazität

ist linear in der Leistung, aber unempfindlich gegenüber Bandbreite. Dies nennt man das Machtbegrenztes Regime.

Das bandbreitenbegrenzte Regime und das leistungsbegrenzte Regime sind in der Figur dargestellt.

Frequenzselektiver AWGN-Kanal[edit]

Die Kapazität des frequenzselektiven Kanals ergibt sich aus der sogenannten Wasserfüllleistungszuweisung,

wo

und

ist der Gewinn des Unterkanals

mit

ausgewählt, um die Leistungsbeschränkung zu erfüllen.

Langsam verblassender Kanal[edit]

In einem langsam verblassenden Kanal, in dem die Kohärenzzeit größer als die Latenzzeit ist, gibt es keine bestimmte Kapazität als maximale Rate zuverlässiger Kommunikation, die vom Kanal unterstützt wird.

hängt von der zufälligen Kanalverstärkung ab

, die dem Sender unbekannt ist. Wenn der Sender Daten mit einer Rate codiert

[bits/s/Hz]gibt es eine Wahrscheinlichkeit ungleich Null, dass die Decodierungsfehlerwahrscheinlichkeit nicht beliebig klein gemacht werden kann,

- ,

In diesem Fall soll das System ausfallen. Mit einer Wahrscheinlichkeit ungleich Null, dass sich der Kanal in einem tiefen Fade befindet, ist die Kapazität des langsam verblassenden Kanals im engeren Sinne Null. Es ist jedoch möglich, den größten Wert von zu bestimmen

so dass die Ausfallwahrscheinlichkeit

ist weniger als

. Dieser Wert wird als bezeichnet

Ausfallkapazität.

Schnell verblassender Kanal[edit]

In einem schnell verblassenden Kanal, in dem die Latenzzeit größer als die Kohärenzzeit ist und die Codewortlänge viele Kohärenzperioden umfasst, kann man über viele unabhängige Kanalüberblendungen mittels Codierung über eine große Anzahl von Kohärenzzeitintervallen mitteln. Somit ist es möglich, eine zuverlässige Kommunikationsrate von zu erreichen

[bits/s/Hz] und es ist sinnvoll, von diesem Wert als der Kapazität des schnell verblassenden Kanals zu sprechen.

Siehe auch[edit]

Fortgeschrittene Kommunikationsthemen[edit]

Externe Links[edit]

Verweise[edit]

- ^ Saleem Bhatti. “Kanalkapazität”. Vorlesungsunterlagen für M.Sc. Datenkommunikationsnetze und verteilte Systeme D51 – Grundlegende Kommunikation und Netzwerke. Archiviert von das Original am 21.08.2007.

- ^ Jim Lesurf. “Signale sehen aus wie Rauschen!”. Information und Messung, 2. Aufl.

- ^ Thomas M. Cover, Joy A. Thomas (2006). Elemente der Informationstheorie. John Wiley & Sons, New York. ISBN 9781118585771.

- ^ Cover, Thomas M.; Thomas, Joy A. (2006). “Kapitel 7: Kanalkapazität”. Elemente der Informationstheorie (Zweite Ausgabe). Wiley-Interscience. S. 206–207. ISBN 978-0-471-24195-9.

- ^ Lovász, László (1979), “Über die Shannon-Kapazität eines Graphen”, IEEE-Transaktionen zur Informationstheorie, IT-25 (1): 1–7, doi:10.1109 / tit.1979.1055985.

- ^ David Tse, Pramod Viswanath (2005), Grundlagen der drahtlosen Kommunikation, Cambridge University Press, Großbritannien, ISBN 9780521845274

- ^ Das Handbuch der Elektrotechnik. Verband für Forschung und Bildung. 1996. p. D-149. ISBN 9780878919819.

und

und  als Zufallsvariablen modelliert werden. Weiterhin lassen

als Zufallsvariablen modelliert werden. Weiterhin lassen  sei die bedingte Wahrscheinlichkeitsverteilungsfunktion von

sei die bedingte Wahrscheinlichkeitsverteilungsfunktion von  bestimmt die gemeinsame Verteilung vollständig

bestimmt die gemeinsame Verteilung vollständig  aufgrund der Identität

aufgrund der Identität

. Das Kanalkapazität ist definiert als

. Das Kanalkapazität ist definiert als

und

und  zwei unabhängige Kanäle sein, die wie oben modelliert sind;

zwei unabhängige Kanäle sein, die wie oben modelliert sind;  und ein Ausgabealphabet

und ein Ausgabealphabet  . Idem für

. Idem für  wie

wie

.

.

und

und  zwei unabhängige Zufallsvariablen sein. Lassen

zwei unabhängige Zufallsvariablen sein. Lassen  eine Zufallsvariable sein, die der Ausgabe von entspricht

eine Zufallsvariable sein, die der Ausgabe von entspricht  zum

zum  .

.

ist unabhängig von

ist unabhängig von  . Wir können die folgende Eigenschaft der gegenseitigen Information anwenden:

. Wir können die folgende Eigenschaft der gegenseitigen Information anwenden:

so dass

so dass  . Eigentlich,

. Eigentlich,  und

und  zwei Wahrscheinlichkeitsverteilungen für

zwei Wahrscheinlichkeitsverteilungen für  und

und  , genügen:

, genügen:

.

.

eine Verteilung für den Kanal sein

eine Verteilung für den Kanal sein  und die entsprechende Ausgabe

und die entsprechende Ausgabe  . Lassen

. Lassen  und

und  .

.

. Für ein bestimmtes Paar

. Für ein bestimmtes Paar  können wir umschreiben

können wir umschreiben  wie:

wie:

![{ displaystyle { begin {align} H (Y_ {1}, Y_ {2} | X_ {1}, X_ {2} = x_ {1}, x_ {2}) & = sum _ {(y_ { 1}, y_ {2}) in { mathcal {Y}} _ {1} times { mathcal {Y}} _ {2}} mathbb {P} (Y_ {1}, Y_ {2} = y_ {1}, y_ {2} | X_ {1}, X_ {2} = x_ {1}, x_ {2}) log ( mathbb {P} (Y_ {1}, Y_ {2} = y_ {1}, y_ {2} | X_ {1}, X_ {2} = x_ {1}, x_ {2})) \ & = sum _ {(y_ {1}, y_ {2}) in { mathcal {Y}} _ {1} times { mathcal {Y}} _ {2}} mathbb {P} (Y_ {1}, Y_ {2} = y_ {1}, y_ { 2} | X_ {1}, X_ {2} = x_ {1}, x_ {2})[log(mathbb {P} (Y_{1}=y_{1}|X_{1}=x_{1}))+log(mathbb {P} (Y_{2}=y_{2}|X_{2}=x_{2}))]\ & = H (Y_ {1} | X_ {1} = x_ {1}) + H (Y_ {2} | X_ {2} = x_ {2}) end {align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/733594496825a6d2bf9543f0df96fe19033e9c58)

.

.

.

.

[W]beträgt die Gesamtbandbreite

[W]beträgt die Gesamtbandbreite  in Hertz, und die Rauschleistungsspektraldichte ist

in Hertz, und die Rauschleistungsspektraldichte ist  [W/Hz]beträgt die AWGN-Kanalkapazität

[W/Hz]beträgt die AWGN-Kanalkapazität

ist das empfangene Signal-Rausch-Verhältnis (SNR). Dieses Ergebnis ist als bekannt Shannon-Hartley-Theorem.[7]

ist das empfangene Signal-Rausch-Verhältnis (SNR). Dieses Ergebnis ist als bekannt Shannon-Hartley-Theorem.[7] ist logarithmisch in der Leistung und ungefähr linear in der Bandbreite. Dies nennt man das bandbreitenbegrenztes Regime.

ist logarithmisch in der Leistung und ungefähr linear in der Bandbreite. Dies nennt man das bandbreitenbegrenztes Regime.

ist linear in der Leistung, aber unempfindlich gegenüber Bandbreite. Dies nennt man das Machtbegrenztes Regime.

ist linear in der Leistung, aber unempfindlich gegenüber Bandbreite. Dies nennt man das Machtbegrenztes Regime.

und

und  ist der Gewinn des Unterkanals

ist der Gewinn des Unterkanals  mit

mit  ausgewählt, um die Leistungsbeschränkung zu erfüllen.

ausgewählt, um die Leistungsbeschränkung zu erfüllen.

hängt von der zufälligen Kanalverstärkung ab

hängt von der zufälligen Kanalverstärkung ab  , die dem Sender unbekannt ist. Wenn der Sender Daten mit einer Rate codiert

, die dem Sender unbekannt ist. Wenn der Sender Daten mit einer Rate codiert  [bits/s/Hz]gibt es eine Wahrscheinlichkeit ungleich Null, dass die Decodierungsfehlerwahrscheinlichkeit nicht beliebig klein gemacht werden kann,

[bits/s/Hz]gibt es eine Wahrscheinlichkeit ungleich Null, dass die Decodierungsfehlerwahrscheinlichkeit nicht beliebig klein gemacht werden kann,

ist weniger als

ist weniger als  . Dieser Wert wird als bezeichnet

. Dieser Wert wird als bezeichnet  [bits/s/Hz] und es ist sinnvoll, von diesem Wert als der Kapazität des schnell verblassenden Kanals zu sprechen.

[bits/s/Hz] und es ist sinnvoll, von diesem Wert als der Kapazität des schnell verblassenden Kanals zu sprechen.

Recent Comments