Matrix (Mathematik) – Wikipedia

Zweidimensionales Array von Zahlen mit bestimmten Operationen

In der Mathematik a Matrix (Plural Matrizen) ist ein Rechteck Array oder Tabelle von Zahlen, Symbolen oder Ausdrücken, angeordnet in Reihen und Säulen.[1][2] Die folgende Dimension der Matrix beträgt beispielsweise 2 × 3 (lesen Sie “zwei mal drei”), da zwei Zeilen und drei Spalten vorhanden sind:

Vorausgesetzt, sie haben die gleiche Größe (jede Matrix hat die gleiche Anzahl von Zeilen und die gleiche Anzahl von Spalten wie die andere), können zwei Matrizen Element für Element addiert oder subtrahiert werden (siehe anpassbare Matrix). Die Regel für die Matrixmultiplikation lautet jedoch: Zwei Matrizen können nur multipliziert werden, wenn die Anzahl der Spalten in der ersten der Anzahl der Zeilen in der zweiten entspricht (dh die inneren Abmessungen sind die gleichen, n für ein (m×n) -Matrix mal ein (n×p) -Matrix, was zu einem (m×p)-Matrix). Umgekehrt gibt es kein Produkt – ein erster Hinweis darauf, dass die Matrixmultiplikation nicht kommutativ ist. Jede Matrix kann elementweise mit einem Skalar aus dem zugehörigen Feld multipliziert werden. Matrizen werden oft mit römischen Großbuchstaben wie bezeichnet

,

und

.[3]

Die einzelnen Artikel in einem m×n Matrix EIN, oft bezeichnet mit einich,j, wo ich und j variieren normalerweise von 1 bis m und nwerden jeweils als its bezeichnet Elemente oder Einträge.[4][5] Um ein Element der Ergebnisse von Matrixoperationen bequem auszudrücken, werden die Indizes des Elements häufig an den Matrixausdruck in Klammern oder in Klammern angehängt (z.AB)ich,j bezieht sich auf ein Element eines Matrixprodukts). Im Zusammenhang mit der abstrakten Indexnotation bezieht sich dies mehrdeutig auch auf das gesamte Matrixprodukt.

Eine Hauptanwendung von Matrizen ist die Darstellung linearer Transformationen, dh Verallgemeinerungen linearer Funktionen wie z f((x) = 4x. Beispielsweise ist die Rotation von Vektoren im dreidimensionalen Raum eine lineare Transformation, die durch eine Rotationsmatrix dargestellt werden kann R.: wenn v ist ein Spaltenvektor (eine Matrix mit nur einer Spalte), der die Position eines Punktes im Raum, des Produkts, beschreibt Rv ist ein Spaltenvektor, der die Position dieses Punktes nach einer Drehung beschreibt. Das Produkt zweier Transformationsmatrizen ist eine Matrix, die die Zusammensetzung zweier Transformationen darstellt. Eine weitere Anwendung von Matrizen ist die Lösung linearer Gleichungssysteme.

Wenn die Matrix quadratisch ist, ist es möglich, einige ihrer Eigenschaften durch Berechnung ihrer Determinante abzuleiten. Zum Beispiel hat eine quadratische Matrix genau dann eine Umkehrung, wenn ihre Determinante nicht Null ist. Ein Einblick in die Geometrie einer linearen Transformation ist (zusammen mit anderen Informationen) aus den Eigenwerten und Eigenvektoren der Matrix erhältlich.

Anwendungen von Matrizen finden sich in den meisten wissenschaftlichen Bereichen.[6] In allen Bereichen der Physik, einschließlich der klassischen Mechanik, Optik, Elektromagnetismus, Quantenmechanik und Quantenelektrodynamik, werden physikalische Phänomene wie die Bewegung starrer Körper untersucht.

In der Computergrafik werden sie verwendet, um 3D-Modelle zu bearbeiten und auf einen zweidimensionalen Bildschirm zu projizieren. In der Wahrscheinlichkeitstheorie und -statistik werden stochastische Matrizen verwendet, um Sätze von Wahrscheinlichkeiten zu beschreiben. Sie werden beispielsweise im PageRank-Algorithmus verwendet, mit dem die Seiten in einer Google-Suche eingestuft werden.[7]Die Matrixrechnung verallgemeinert klassische analytische Begriffe wie Ableitungen und Exponentiale auf höhere Dimensionen. Matrizen werden in der Wirtschaft verwendet, um Systeme wirtschaftlicher Beziehungen zu beschreiben.

Ein Hauptzweig der numerischen Analyse ist der Entwicklung effizienter Algorithmen für Matrixberechnungen gewidmet, ein Thema, das Jahrhunderte alt ist und heute ein wachsendes Forschungsgebiet darstellt. Matrixzerlegungsmethoden vereinfachen Berechnungen sowohl theoretisch als auch praktisch. Algorithmen, die auf bestimmte Matrixstrukturen zugeschnitten sind, wie z. B. dünn besetzte Matrizen und nahezu diagonale Matrizen, beschleunigen Berechnungen in der Finite-Elemente-Methode und andere Berechnungen. Unendliche Matrizen kommen in der Planetentheorie und in der Atomtheorie vor. Ein einfaches Beispiel für eine unendliche Matrix ist die Matrix, die den Ableitungsoperator darstellt, der auf die Taylor-Reihe einer Funktion einwirkt.

Definition[edit]

EIN Matrix ist ein rechteckiges Array von Zahlen (oder anderen mathematischen Objekten), für die Operationen wie Addition und Multiplikation definiert sind.[8] Am häufigsten eine Matrix über einem Feld F. ist eine rechteckige Anordnung von Skalaren, von denen jeder Mitglied von ist F..[9][10] Der größte Teil dieses Artikels konzentriert sich auf echt und komplexe Matrizendas heißt, Matrizen, deren Elemente jeweils reelle Zahlen oder komplexe Zahlen sind. Allgemeinere Arten von Einträgen werden unten diskutiert. Zum Beispiel ist dies eine echte Matrix:

Die Zahlen, Symbole oder Ausdrücke in der Matrix werden als its bezeichnet Einträge oder seine Elemente. Die horizontalen und vertikalen Zeilen von Einträgen in einer Matrix werden aufgerufen Reihen und Säulen, beziehungsweise.

Größe[edit]

Die Größe einer Matrix wird durch die Anzahl der darin enthaltenen Zeilen und Spalten definiert. Eine Matrix mit m Zeilen und n Spalten heißt ein m × n Matrix oder m-durch-n Matrix, während m und n werden seine genannt Maße. Zum Beispiel die Matrix EIN oben ist eine 3 × 2 Matrix.

Matrizen mit einer einzelnen Zeile werden aufgerufen Zeilenvektorenund diejenigen mit einer einzelnen Spalte werden aufgerufen Spaltenvektoren. Eine Matrix mit der gleichen Anzahl von Zeilen und Spalten heißt a quadratische Matrix.[11] Eine Matrix mit einer unendlichen Anzahl von Zeilen oder Spalten (oder beiden) wird als bezeichnet unendliche Matrix. In einigen Kontexten, wie z. B. bei Computeralgebraprogrammen, ist es nützlich, eine Matrix ohne Zeilen oder Spalten zu betrachten, die als bezeichnet wird leere Matrix.

| Name | Größe | Beispiel | Beschreibung |

|---|---|---|---|

| Zeilenvektor | 1 × n | Eine Matrix mit einer Zeile, die manchmal zur Darstellung eines Vektors verwendet wird | |

| Spaltenvektor | n × 1 | Eine Matrix mit einer Spalte, die manchmal zur Darstellung eines Vektors verwendet wird | |

| Quadratische Matrix | n × n | Eine Matrix mit der gleichen Anzahl von Zeilen und Spalten, die manchmal verwendet wird, um eine lineare Transformation von einem Vektorraum zu sich selbst darzustellen, z. B. Reflexion, Drehung oder Scherung. |

Notation[edit]

Matrizen werden üblicherweise in Klammern oder Klammern geschrieben:

Die Besonderheiten der symbolischen Matrixnotation variieren stark, wobei einige Trends vorherrschen. Matrizen werden normalerweise durch Großbuchstaben symbolisiert (z EIN in den obigen Beispielen),[3] während die entsprechenden Kleinbuchstaben mit zwei tiefgestellten Indizes (z. ein11, oder ein1,1), repräsentieren die Einträge. Zusätzlich zur Verwendung von Großbuchstaben zur Symbolisierung von Matrizen verwenden viele Autoren einen speziellen typografischen Stil, der häufig fett (nicht kursiv) fett gedruckt ist, um Matrizen weiter von anderen mathematischen Objekten zu unterscheiden. Eine alternative Notation beinhaltet die Verwendung einer doppelten Unterstreichung mit dem Variablennamen mit oder ohne Fettdruck (wie im Fall von

).

Der Eintrag in der ich-te Reihe und j-te Spalte einer Matrix EIN wird manchmal als die bezeichnet ich,j, (ich,j), oder (ich,j) der Eintrag der Matrix und am häufigsten als bezeichnet einich,j, oder einij. Alternative Notationen für diesen Eintrag sind EIN[i,j] oder EINich, j. Zum Beispiel der (1,3) -Eintrag der folgenden Matrix EIN ist 5 (auch bezeichnet ein13, ein1,3, EIN[1,3] oder EIN1,3):

Manchmal können die Einträge einer Matrix durch eine Formel wie definiert werden einich,j = f((ich, j). Zum Beispiel jeder der Einträge der folgenden Matrix EIN wird durch die Formel bestimmt einij = ich – – j.

In diesem Fall wird die Matrix selbst manchmal durch diese Formel in eckigen Klammern oder doppelten Klammern definiert. Zum Beispiel ist die obige Matrix definiert als EIN = [i−j], oder EIN = ((ich– –j)). Wenn die Matrixgröße ist m × ndie oben genannte Formel f((ich, j) gilt für alle ich = 1, …, m und alle j = 1, …, n. Dies kann entweder separat angegeben oder mit angegeben werden m × n als Index. Zum Beispiel die Matrix EIN oben ist 3 × 4 und kann definiert werden als EIN = [i − j] ((ich = 1, 2, 3; j = 1, …, 4) oder EIN = [i − j]3×4.

Einige Programmiersprachen verwenden doppelt tiefgestellte Arrays (oder Arrays von Arrays), um ein darzustellen m– × –n Matrix. Einige Programmiersprachen beginnen die Nummerierung von Array-Indizes bei Null. In diesem Fall werden die Einträge von a m-durch-n Matrix werden durch indiziert 0 ≤ ich ≤ m – 1 und 0 ≤ j ≤ n – 1.[12] Dieser Artikel folgt der allgemeineren Konvention im mathematischen Schreiben, bei der die Aufzählung bei 1 beginnt.

Gelegentlich wird ein Sternchen verwendet, um auf ganze Zeilen oder Spalten in einer Matrix zu verweisen. Zum Beispiel, einich, ∗ bezieht sich auf die ith Reihe von EIN, und ein∗,j bezieht sich auf die jth Spalte von EIN. Das Set von allen m-durch-n Matrizen werden mit 𝕄 (m, n).

Grundoperationen[edit]

Es gibt eine Reihe grundlegender Operationen, die zum Ändern von Matrizen angewendet werden können Matrixaddition, Skalarmultiplikation, Umsetzung, Matrix-Multiplikation, Zeilenoperationen, und Submatrix.[14]

Addition, Skalarmultiplikation und Transposition[edit]

| Betrieb | Definition | Beispiel |

|---|---|---|

| Zusatz | Das Summe EIN+B. von zwei m-durch-n Matrizen EIN und B. wird eingangs berechnet:

|

|

| Skalarmultiplikation | Das Produkt cEIN einer Zahl c (im Sprachgebrauch der abstrakten Algebra auch Skalar genannt) und eine Matrix EIN wird berechnet, indem jeder Eintrag von multipliziert wird EIN durch c::

Diese Operation wird aufgerufen SkalarmultiplikationDas Ergebnis wird jedoch nicht als “Skalarprodukt” bezeichnet, um Verwirrung zu vermeiden, da “Skalarprodukt” manchmal als Synonym für “inneres Produkt” verwendet wird. |

|

| Umsetzung | Das transponieren eines m-durch-n Matrix EIN ist der n-durch-m Matrix EINT. (auch bezeichnet EINtr oder tEIN) gebildet durch Verwandeln von Zeilen in Spalten und umgekehrt:

|

Bekannte Eigenschaften von Zahlen erstrecken sich auf diese Operationen von Matrizen: Beispielsweise ist die Addition kommutativ, dh die Matrixsumme hängt nicht von der Reihenfolge der Summanden ab: EIN + B. = B. + EIN.[15]

Die Transponierte ist kompatibel mit Addition und Skalarmultiplikation, ausgedrückt durch (cEIN)T. = c((EINT.) und (EIN + B.)T. = EINT. + B.T.. Schließlich, (EINT.)T. = EIN.

Matrix-Multiplikation[edit]

Multiplikation von zwei Matrizen wird genau dann definiert, wenn die Anzahl der Spalten der linken Matrix der Anzahl der Zeilen der rechten Matrix entspricht. Wenn EIN ist ein m-durch-n Matrix und B. ist ein n-durch-p Matrix, dann ihre Matrixprodukt AB ist der m-durch-p Matrix, deren Einträge durch das Punktprodukt der entsprechenden Zeile von gegeben sind EIN und die entsprechende Spalte von B.::[16]

wo 1 ≤ ich ≤ m und 1 ≤ j ≤ p.[17] Beispielsweise wird der unterstrichene Eintrag 2340 im Produkt berechnet als (2 × 1000) + (3 × 100) + (4 × 10) = 2340:

Die Matrixmultiplikation erfüllt die Regeln (AB)C. = EIN((BC) (Assoziativität) und (EIN + B.)C. = AC + BC ebenso gut wie C.((EIN + B.) = CA. + CB (linke und rechte Verteilbarkeit), wenn die Größe der Matrizen so ist, dass die verschiedenen Produkte definiert sind.[18] Das Produkt AB kann ohne definiert werden BA definiert werden, nämlich wenn EIN und B. sind m-durch-n und n-durch-k Matrizen bzw. und m ≠ k. Selbst wenn beide Produkte definiert sind, müssen sie im Allgemeinen nicht gleich sein, dh:

- AB ≠ BA,

Mit anderen Worten, Matrixmultiplikation ist nicht kommutativ, in deutlichem Kontrast zu (rationalen, reellen oder komplexen) Zahlen, deren Produkt unabhängig von der Reihenfolge der Faktoren ist.[16] Ein Beispiel für zwei Matrizen, die nicht miteinander pendeln, ist:

wohingegen

Neben der eben beschriebenen gewöhnlichen Matrixmultiplikation existieren auch andere weniger häufig verwendete Operationen an Matrizen, die als Multiplikationsformen angesehen werden können, wie das Hadamard-Produkt und das Kronecker-Produkt.[19] Sie entstehen beim Lösen von Matrixgleichungen wie der Sylvester-Gleichung.

Zeilenoperationen[edit]

Es gibt drei Arten von Zeilenoperationen:

- Zeilenaddition, dh Hinzufügen einer Zeile zu einer anderen.

- Zeilenmultiplikation, dh Multiplizieren aller Einträge einer Zeile mit einer Konstante ungleich Null;

- Zeilenumschaltung, dh Austausch zweier Zeilen einer Matrix;

Diese Operationen werden auf verschiedene Arten verwendet, einschließlich des Lösens linearer Gleichungen und des Findens von Matrixinversen.

Submatrix[edit]

EIN Submatrix einer Matrix wird durch Löschen einer beliebigen Sammlung von Zeilen und / oder Spalten erhalten.[20][21][22] Aus der folgenden 3-mal-4-Matrix können wir beispielsweise eine 2-mal-3-Submatrix erstellen, indem wir Zeile 3 und Spalte 2 entfernen:

Die Minderjährigen und Cofaktoren einer Matrix werden durch Berechnung der Determinante bestimmter Submatrizen ermittelt.[22][23]

EIN Haupt-Submatrix ist eine quadratische Submatrix, die durch Entfernen bestimmter Zeilen und Spalten erhalten wird. Die Definition variiert von Autor zu Autor. Nach Ansicht einiger Autoren ist eine Haupt-Submatrix eine Submatrix, bei der die Menge der verbleibenden Zeilenindizes dieselbe ist wie die Menge der verbleibenden Spaltenindizes.[24][25] Andere Autoren definieren eine Haupt-Submatrix als eine, in der die erste k Zeilen und Spalten für eine bestimmte Anzahl ksind diejenigen, die bleiben;[26] Diese Art von Submatrix wurde auch als a bezeichnet führende Haupt-Submatrix.[27]

Lineare Gleichungen[edit]

Matrizen können verwendet werden, um mehrere lineare Gleichungen, dh lineare Gleichungssysteme, kompakt zu schreiben und damit zu arbeiten. Zum Beispiel, wenn EIN ist ein m-durch-n Matrix, x bezeichnet einen Spaltenvektor (d. h. n× 1-Matrix) von n Variablen x1, x2, …, xn, und b ist ein m× 1-Spalten-Vektor, dann die Matrixgleichung

entspricht dem linearen Gleichungssystem[28]

Mit Hilfe von Matrizen kann dies kompakter gelöst werden, als dies durch separates Schreiben aller Gleichungen möglich wäre. Wenn n = m und die Gleichungen sind unabhängig, dann kann dies durch Schreiben erfolgen

wo EIN−1 ist die inverse Matrix von EIN. Wenn EIN hat keine Umkehrung, Lösungen – wenn überhaupt – können mit ihrer verallgemeinerten Umkehrung gefunden werden.

Lineare Transformationen[edit]

Matrizen und Matrixmultiplikation zeigen ihre wesentlichen Merkmale in Bezug auf lineare Transformationen, auch bekannt als lineare Karten. Ein echter m-durch-n Matrix EIN führt zu einer linearen Transformation R.n → R.m Abbildung jedes Vektors x im R.n zum (Matrix-) Produkt Axt, das ist ein Vektor in R.m. Umgekehrt jede lineare Transformation f:: R.n → R.m entsteht aus einem einzigartigen m-durch-n Matrix EIN: explizit die ((ich, j)-Eintrag von EIN ist der ichth Koordinate von f((ej), wo ej = (0, …, 0,1,0, …, 0) ist der Einheitsvektor mit 1 in der jth Position und 0 anderswo. Die Matrix EIN soll die lineare Karte darstellen f, und EIN heißt das Transformationsmatrix von f.

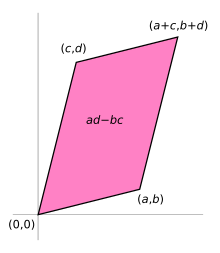

Zum Beispiel die 2 × 2-Matrix

kann als Transformation des Einheitsquadrats in ein Parallelogramm mit Eckpunkten bei angesehen werden (0, 0), ((ein, b), ((ein + c, b + d), und ((c, d). Das rechts abgebildete Parallelogramm wird durch Multiplikation erhalten EIN mit jedem der Spaltenvektoren

, und

im Gegenzug. Diese Vektoren definieren die Eckpunkte des Einheitsquadrats.

Die folgende Tabelle zeigt eine Anzahl von 2-mal-2-Matrizen mit den zugehörigen linearen Karten von R.2. Das blaue Original wird dem grünen Raster und den Formen zugeordnet. Der Ursprung (0,0) ist mit einem schwarzen Punkt markiert.

Bei der 1-zu-1-Entsprechung zwischen Matrizen und linearen Karten entspricht die Matrixmultiplikation der Zusammensetzung der Karten:[29] wenn ein k-durch-m Matrix B. repräsentiert eine andere lineare Karte G:: R.m → R.k, dann die Zusammensetzung G ∘ f wird vertreten durch BA schon seit

- ((G ∘ f) (x) = G((f((x)) = G((Axt) = B.((Axt) = (BA)x.

Die letzte Gleichheit ergibt sich aus der oben erwähnten Assoziativität der Matrixmultiplikation.

Der Rang einer Matrix EIN ist die maximale Anzahl linear unabhängiger Zeilenvektoren der Matrix, die der maximalen Anzahl linear unabhängiger Spaltenvektoren entspricht.[30] Entsprechend ist es die Dimension des Bildes der linearen Karte, dargestellt durch EIN.[31] Der Rang-Null-Satz besagt, dass die Dimension des Kernels einer Matrix plus des Ranges der Anzahl der Spalten der Matrix entspricht.[32]

Quadratische Matrix[edit]

Eine quadratische Matrix ist eine Matrix mit der gleichen Anzahl von Zeilen und Spalten.[11] Ein n-durch-n Matrix ist als quadratische Matrix der Ordnung bekannt n. Zwei beliebige quadratische Matrizen derselben Reihenfolge können addiert und multipliziert werden. Die Einträge einii bilden die Hauptdiagonale einer quadratischen Matrix. Sie liegen auf der imaginären Linie, die von der oberen linken Ecke zur unteren rechten Ecke der Matrix verläuft.

Haupttypen[edit]

-

Name Beispiel mit n = 3 Diagonale Matrix Untere dreieckige Matrix Obere Dreiecksmatrix

Diagonale und dreieckige Matrix[edit]

Wenn alle Einträge von EIN unterhalb der Hauptdiagonale sind Null, EIN heißt ein obere dreieckige Matrix. Ebenso, wenn alle Einträge von EIN über der Hauptdiagonale sind Null, EIN heißt a untere dreieckige Matrix. Wenn alle Einträge außerhalb der Hauptdiagonale Null sind, EIN wird eine Diagonalmatrix genannt.

Identitätsmatrix[edit]

Das Identitätsmatrix ichn von Größe n ist der n-durch-n Matrix, in der alle Elemente auf der Hauptdiagonale gleich 1 sind und alle anderen Elemente gleich 0 sind, z.

Es ist eine quadratische Ordnungsmatrix nund auch eine spezielle Art von Diagonalmatrix. Es wird als Identitätsmatrix bezeichnet, da durch Multiplikation eine Matrix unverändert bleibt:

- AIn = ichmEIN = EIN für jeden m-durch-n Matrix EIN.

Ein skalares Vielfaches einer Identitätsmatrix ungleich Null wird als a bezeichnet Skalar Matrix. Wenn die Matrixeinträge aus einem Feld stammen, bilden die Skalarmatrizen unter Matrixmultiplikation eine Gruppe, die isomorph zur multiplikativen Gruppe von Nicht-Null-Elementen des Feldes ist.

Symmetrische oder schiefsymmetrische Matrix[edit]

Eine quadratische Matrix EIN das ist gleich seiner Transponierung, das heißt, EIN = EINT.ist eine symmetrische Matrix. Wenn stattdessen EIN ist gleich dem Negativ seiner Transponierung, das heißt, EIN = –EINT., dann EIN ist eine schrägsymmetrische Matrix. In komplexen Matrizen wird die Symmetrie häufig durch das Konzept der hermitischen Matrizen ersetzt, die befriedigen EIN∗ = EINwobei der Stern oder das Sternchen die konjugierte Transponierte der Matrix bezeichnet, dh die Transponierte des komplexen Konjugats von EIN.

Nach dem Spektralsatz haben reale symmetrische Matrizen und komplexe hermitianische Matrizen eine Eigenbasis; Das heißt, jeder Vektor kann als lineare Kombination von Eigenvektoren ausgedrückt werden. In beiden Fällen sind alle Eigenwerte real.[33] Dieser Satz kann auf unendlich dimensionale Situationen verallgemeinert werden, die sich auf Matrizen mit unendlich vielen Zeilen und Spalten beziehen, siehe unten.

Invertierbare Matrix und ihre Umkehrung[edit]

Eine quadratische Matrix EIN wird genannt invertierbar oder nicht singulär wenn es eine Matrix gibt B. so dass

- AB = BA = ichn ,[34][35]

wo ichn ist der n×n Identitätsmatrix mit 1s auf der Hauptdiagonale und 0s an anderer Stelle. Wenn B. existiert, es ist einzigartig und heißt das inverse Matrix von EINbezeichnet EIN−1.

Bestimmte Matrix[edit]

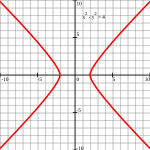

| Positive definitive Matrix | Unbestimmte Matrix |

|---|---|

| Q.((x, y) = 1/4 x2 + y2 | Q.((x, y) = 1/4 x2 – 1/4 y2 |

Punkte so, dass Q.((x,y) = 1 (Ellipse). |

Punkte so, dass Q.((x,y) = 1 (Hyperbel). |

Eine symmetrische n×n-Matrix EIN wird genannt positiv-definitiv wenn die zugehörige quadratische Form

- f ((x) = xT.EIN x

hat einen positiven Wert für jeden Vektor ungleich Null x im R.n. Wenn f ((x) ergibt dann nur negative Werte EIN ist negativ-definitiv;; wenn f erzeugt dann sowohl negative als auch positive Werte EIN ist unbestimmt.[36] Ist die quadratische Form f ergibt nur nicht negative Werte (positiv oder null), die symmetrische Matrix heißt positiv-semidefinit (oder wenn nur nicht positive Werte, dann negativ-semidefinit); daher ist die Matrix genau dann unbestimmt, wenn sie weder positiv-semidefinit noch negativ-semidefinit ist.

Eine symmetrische Matrix ist genau dann positiv definit, wenn alle ihre Eigenwerte positiv sind, dh die Matrix ist positiv-semidefinit und invertierbar.[37] Die Tabelle rechts zeigt zwei Möglichkeiten für 2-mal-2-Matrizen.

Wenn stattdessen zwei verschiedene Vektoren als Eingabe zugelassen werden, ergibt sich die damit verbundene bilineare Form EIN::

- B.EIN ((x, y) = xT.Ja.[38]

Orthogonale Matrix[edit]

Ein orthogonale Matrix ist eine quadratische Matrix mit reellen Einträgen, deren Spalten und Zeilen orthogonale Einheitsvektoren (dh orthonormale Vektoren) sind. Entsprechend eine Matrix EIN ist orthogonal, wenn seine Transponierung gleich seiner Umkehrung ist:

was bedeutet

wo ichn ist die Identitätsmatrix der Größe n.

Eine orthogonale Matrix EIN ist notwendigerweise invertierbar (mit invers EIN−1 = EINT.), einheitlich (EIN−1 = EIN* *) und normal (EIN* *EIN = AA* *). Die Determinante einer orthogonalen Matrix ist entweder +1 oder −1. EIN spezielle orthogonale Matrix ist eine orthogonale Matrix mit der Determinante +1. Als lineare Transformation jede orthogonale Matrix mit Determinante +1 ist eine reine Rotation ohne Reflexion, dh die Transformation behält die Orientierung der transformierten Struktur bei, während jede orthogonale Matrix mit Determinante -1 kehrt die Orientierung um, dh ist eine Zusammensetzung einer reinen Reflexion und einer (möglicherweise Null-) Rotation. Die Identitätsmatrizen haben eine Determinante 1und sind reine Rotationen um einen Winkel Null.

Das komplexe Analogon einer orthogonalen Matrix ist eine einheitliche Matrix.

Hauptoperationen[edit]

Spur[edit]

Die Spur, tr (EIN) einer quadratischen Matrix EIN ist die Summe seiner diagonalen Einträge. Während die Matrixmultiplikation nicht wie oben erwähnt kommutativ ist, ist die Spur des Produkts zweier Matrizen unabhängig von der Reihenfolge der Faktoren:

- tr (AB) = tr (BA).

Dies ergibt sich unmittelbar aus der Definition der Matrixmultiplikation:

Daraus folgt, dass die Spur des Produkts von mehr als zwei Matrizen unabhängig von zyklischen Permutationen der Matrizen ist, dies gilt jedoch im Allgemeinen nicht für beliebige Permutationen (z. B. tr (ABC) ≠ tr (BAC), im Allgemeinen). Außerdem ist die Spur einer Matrix gleich der ihrer Transponierten, d. H.

- tr (EIN) = tr (EINT.).

Bestimmend[edit]

Das bestimmend einer quadratischen Matrix EIN (bezeichnet det (EIN) oder |EIN|[3]) ist eine Zahl, die bestimmte Eigenschaften der Matrix codiert. Eine Matrix ist genau dann invertierbar, wenn ihre Determinante ungleich Null ist. Sein absoluter Wert entspricht der Fläche (in R.2) oder Lautstärke (in R.3) des Bildes des Einheitsquadrats (oder Würfels), während sein Vorzeichen der Ausrichtung der entsprechenden linearen Karte entspricht: Die Determinante ist genau dann positiv, wenn die Ausrichtung erhalten bleibt.

Die Determinante von 2-mal-2-Matrizen ist gegeben durch

- [6]

Die Determinante von 3-mal-3-Matrizen umfasst 6 Terme (Regel von Sarrus). Die längere Leibniz-Formel verallgemeinert diese beiden Formeln auf alle Dimensionen.[39]

Die Determinante eines Produkts aus quadratischen Matrizen entspricht dem Produkt ihrer Determinanten:

- det (AB) = det (EIN) · Det (B.).[40]

Durch Hinzufügen eines Vielfachen einer Zeile zu einer anderen Zeile oder eines Vielfachen einer Spalte zu einer anderen Spalte wird die Determinante nicht geändert. Das Vertauschen von zwei Zeilen oder zwei Spalten wirkt sich auf die Determinante aus, indem sie mit -1 multipliziert wird.[41] Mit diesen Operationen kann jede Matrix in eine untere (oder obere) Dreiecksmatrix transformiert werden, und für solche Matrizen entspricht die Determinante dem Produkt der Einträge auf der Hauptdiagonale; Dies bietet eine Methode zur Berechnung der Determinante einer beliebigen Matrix. Schließlich drückt die Laplace-Erweiterung die Determinante in Form von Minderjährigen aus, dh Determinanten kleinerer Matrizen.[42] Diese Erweiterung kann für eine rekursive Definition von Determinanten verwendet werden (wobei als Ausgangsfall die Determinante einer 1-mal-1-Matrix, die ihr eindeutiger Eintrag ist, oder sogar die Determinante einer 0-mal-0-Matrix, die 1 ist, verwendet wird). Dies entspricht der Leibniz-Formel. Determinanten können verwendet werden, um lineare Systeme nach der Cramer-Regel zu lösen, wobei die Division der Determinanten zweier verwandter quadratischer Matrizen dem Wert jeder der Systemvariablen entspricht.[43]

Eigenwerte und Eigenvektoren[edit]

Eine Zahl λ und ein Vektor ungleich Null v befriedigend

- Ein V = λv

werden ein genannt Eigenwert und ein Eigenvektor von EIN, beziehungsweise.[44][45] Die Zahl λ ist ein Eigenwert von a n×n-Matrix EIN dann und nur dann, wenn EIN−λichn ist nicht invertierbar, was äquivalent zu ist

- [46]

Das Polynom pEIN in einem unbestimmten X. gegeben durch Auswertung der Determinante det (X.ichn– –EIN) heißt das charakteristische Polynom von EIN. Es ist ein monisches Polynom vom Grad n. Daher die Polynomgleichung pEIN(λ) = 0 hat höchstens n verschiedene Lösungen, dh Eigenwerte der Matrix.[47] Sie können komplex sein, auch wenn die Einträge von EIN sind real. Nach dem Cayley-Hamilton-Theorem pEIN((EIN) = 0Das heißt, das Ergebnis des Einsetzens der Matrix selbst in ein eigenes charakteristisches Polynom ergibt die Nullmatrix.

Rechenaspekte[edit]

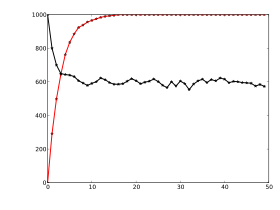

Matrixberechnungen können häufig mit verschiedenen Techniken durchgeführt werden. Viele Probleme können sowohl durch direkte Algorithmen als auch durch iterative Ansätze gelöst werden. Zum Beispiel können die Eigenvektoren einer quadratischen Matrix erhalten werden, indem eine Folge von Vektoren gefunden wird xnKonvergenz zu einem Eigenvektor, wenn n neigt zur Unendlichkeit.[48]

Um den am besten geeigneten Algorithmus für jedes spezifische Problem auszuwählen, ist es wichtig, sowohl die Effektivität als auch die Präzision aller verfügbaren Algorithmen zu bestimmen. Die Domäne, die diese Angelegenheiten untersucht, wird numerische lineare Algebra genannt.[49] Wie bei anderen numerischen Situationen sind zwei Hauptaspekte die Komplexität von Algorithmen und ihre numerische Stabilität.

Um die Komplexität eines Algorithmus zu bestimmen, müssen Obergrenzen oder Schätzungen gefunden werden, wie viele Elementaroperationen wie Additionen und Multiplikationen von Skalaren erforderlich sind, um einen Algorithmus auszuführen, beispielsweise die Multiplikation von Matrizen. Berechnung des Matrixprodukts von zwei n-durch-n Matrizen mit der oben angegebenen Definition benötigen n3 Multiplikationen, da für eine der n2 Einträge des Produkts, n Multiplikationen sind notwendig. Der Strassen-Algorithmus übertrifft diesen “naiven” Algorithmus; es braucht nur n2,807 Multiplikationen.[50] Ein verfeinerter Ansatz beinhaltet auch spezifische Merkmale der Computergeräte.

In vielen praktischen Situationen sind zusätzliche Informationen über die beteiligten Matrizen bekannt. Ein wichtiger Fall sind spärliche Matrizen, dh Matrizen, deren Einträge größtenteils Null sind. Es gibt speziell angepasste Algorithmen, um beispielsweise lineare Systeme zu lösen Axt = b für spärliche Matrizen EIN, wie das konjugierte Gradientenverfahren.[51]

Ein Algorithmus ist grob gesagt numerisch stabil, wenn kleine Abweichungen in den Eingabewerten nicht zu großen Abweichungen im Ergebnis führen. Zum Beispiel die Berechnung der Inversen einer Matrix über die Laplace-Erweiterung (adj (EIN) bezeichnet die Adjugatmatrix von EIN)

- EIN−1 = adj (EIN) / det (EIN)

kann zu signifikanten Rundungsfehlern führen, wenn die Determinante der Matrix sehr klein ist. Die Norm einer Matrix kann verwendet werden, um die Konditionierung linearer algebraischer Probleme zu erfassen, beispielsweise die Berechnung der Inversen einer Matrix.[52]

Die meisten Computerprogrammiersprachen unterstützen Arrays, sind jedoch nicht mit integrierten Befehlen für Matrizen ausgestattet. Stattdessen bieten verfügbare externe Bibliotheken Matrixoperationen für Arrays in fast allen derzeit verwendeten Programmiersprachen. Die Matrixmanipulation gehörte zu den frühesten numerischen Anwendungen von Computern.[53] Das ursprüngliche Dartmouth BASIC hatte seit seiner Implementierung in der zweiten Ausgabe im Jahr 1964 integrierte Befehle für die Matrixarithmetik auf Arrays. Bereits in den 1970er Jahren verfügten einige technische Desktop-Computer wie der HP 9830 über ROM-Kassetten, um BASIC-Befehle für Matrizen hinzuzufügen. Einige Computersprachen wie APL wurden entwickelt, um Matrizen zu manipulieren, und verschiedene mathematische Programme können verwendet werden, um das Rechnen mit Matrizen zu unterstützen.[54]

Zersetzung[edit]

Es gibt verschiedene Methoden, um Matrizen in eine leichter zugängliche Form zu bringen. Sie werden allgemein als bezeichnet Matrixzerlegung oder Matrixfaktorisierung Techniken. Das Interesse all dieser Techniken besteht darin, dass sie bestimmte Eigenschaften der fraglichen Matrizen wie Determinante, Rang oder Inverse beibehalten, so dass diese Größen nach Anwendung der Transformation berechnet werden können oder dass bestimmte Matrixoperationen algorithmisch einfacher durchzuführen sind einige Arten von Matrizen.

Die LU-Zerlegungsfaktoren Matrizen als Produkt von niedrigerem (L.) und eine obere Dreiecksmatrize (U.).[55] Sobald diese Zerlegung berechnet ist, können lineare Systeme durch eine einfache Technik, die als Vorwärts- und Rückwärtssubstitution bezeichnet wird, effizienter gelöst werden. Ebenso sind Inversen dreieckiger Matrizen algorithmisch einfacher zu berechnen. Das Gaußsche Eliminierung ist ein ähnlicher Algorithmus; Es wandelt jede Matrix in eine Reihenebenenform um.[56] Bei beiden Methoden wird die Matrix mit geeigneten Elementarmatrizen multipliziert, die dem Permutieren von Zeilen oder Spalten entsprechen, und Vielfachen einer Zeile zu einer anderen Zeile hinzugefügt. Die Singularwertzerlegung drückt jede Matrix aus EIN als Produkt UDV∗, wo U. und V. sind einheitliche Matrizen und D. ist eine diagonale Matrix.

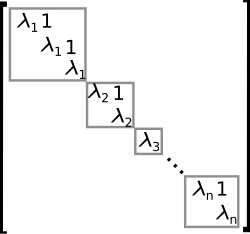

Die Eigenzersetzung oder Diagonalisierung drückt aus EIN als Produkt VDV−1, wo D. ist eine diagonale Matrix und V. ist eine geeignete invertierbare Matrix.[57] Wenn EIN kann in dieser Form geschrieben werden, es heißt diagonalisierbar. Allgemeiner und auf alle Matrizen anwendbar transformiert die Jordan-Zerlegung eine Matrix in die Jordan-Normalform, dh Matrizen, deren einzige Einträge ungleich Null die Eigenwerte λ sind1 zu λn von EIN, platziert auf der Hauptdiagonale und möglicherweise Einträge gleich eins direkt über der Hauptdiagonale, wie rechts gezeigt.[58] Angesichts der Eigenzusammensetzung ist die nth Kraft von EIN (das ist, n-fach iterierte Matrixmultiplikation) kann über berechnet werden

- EINn = (VDV−1)n = VDV−1VDV−1…VDV−1 = VDnV.−1

und die Potenz einer Diagonalmatrix kann berechnet werden, indem die entsprechenden Potenzen der Diagonaleinträge genommen werden, was viel einfacher ist als die Exponentiation für EIN stattdessen. Dies kann verwendet werden, um die Exponentialmatrix zu berechnen eEIN, ein Bedarf, der häufig bei der Lösung linearer Differentialgleichungen, Matrixlogarithmen und Quadratwurzeln von Matrizen auftritt.[59] Um numerisch schlecht konditionierte Situationen zu vermeiden, können weitere Algorithmen wie die Schur-Zerlegung eingesetzt werden.[60]

Abstrakte algebraische Aspekte und Verallgemeinerungen[edit]

Matrizen können auf verschiedene Arten verallgemeinert werden. Die abstrakte Algebra verwendet Matrizen mit Einträgen in allgemeineren Feldern oder sogar Ringen, während die lineare Algebra die Eigenschaften von Matrizen im Begriff der linearen Karten kodiert. Es ist möglich, Matrizen mit unendlich vielen Spalten und Zeilen zu betrachten. Eine weitere Erweiterung sind Tensoren, die als höherdimensionale Anordnungen von Zahlen angesehen werden können, im Gegensatz zu Vektoren, die häufig als Folgen von Zahlen realisiert werden können, während Matrizen rechteckige oder zweidimensionale Anordnungen von Zahlen sind.[61] Matrizen neigen unter bestimmten Anforderungen dazu, Gruppen zu bilden, die als Matrixgruppen bekannt sind. In ähnlicher Weise bilden Matrizen unter bestimmten Bedingungen Ringe, die als Matrixringe bekannt sind. Obwohl das Produkt von Matrizen im Allgemeinen nicht kommutativ ist, bilden bestimmte Matrizen Felder, die als Matrixfelder bekannt sind.

Matrizen mit allgemeineren Einträgen[edit]

Dieser Artikel konzentriert sich auf Matrizen, deren Einträge reelle oder komplexe Zahlen sind. Matrizen können jedoch mit viel allgemeineren Arten von Einträgen als reelle oder komplexe Zahlen betrachtet werden. Als erster Schritt der Verallgemeinerung kann jedes Feld, dh eine Menge, in der Additions-, Subtraktions-, Multiplikations- und Divisionsoperationen definiert sind und sich gut verhalten, anstelle von verwendet werden R. oder C.zum Beispiel rationale Zahlen oder endliche Felder. Beispielsweise verwendet die Codierungstheorie Matrizen über endlichen Feldern. Wenn Eigenwerte berücksichtigt werden, da diese Wurzeln eines Polynoms sind, können sie nur in einem größeren Feld als dem der Einträge der Matrix existieren. Beispielsweise können sie im Fall einer Matrix mit realen Einträgen komplex sein. Die Möglichkeit, die Einträge einer Matrix als Elemente eines größeren Feldes neu zu interpretieren (z. B. eine reale Matrix als komplexe Matrix anzusehen, deren Einträge zufällig alle real sind), ermöglicht es dann, zu berücksichtigen, dass jede quadratische Matrix einen vollständigen Satz von Eigenwerten besitzt. Alternativ kann man nur Matrizen mit Einträgen in einem algebraisch geschlossenen Feld betrachten, wie z C., von vornherein.

Im Allgemeinen Matrizen mit Einträgen in einem Ring R. sind in der Mathematik weit verbreitet.[62] Ringe sind ein allgemeinerer Begriff als Felder, da eine Divisionsoperation nicht existieren muss. Die gleichen Additions- und Multiplikationsoperationen von Matrizen gelten auch für diese Einstellung. Die Menge M (n, R.) aller Quadrate n-durch-n Matrizen vorbei R. ist ein Ring namens Matrixring, isomorph zum Endomorphismusring von links R.-Modul R.n.[63] Wenn der Ring R. ist kommutativ, dh seine Multiplikation ist kommutativ, dann M (n, R.) ist eine einheitliche nicht kommutative (es sei denn n = 1) assoziative Algebra vorbei R.. Die Determinante quadratischer Matrizen über einem kommutativen Ring R. kann weiterhin mit der Leibniz-Formel definiert werden; Eine solche Matrix ist genau dann invertierbar, wenn ihre Determinante invertierbar ist R.Verallgemeinern der Situation über ein Feld F., wobei jedes Element ungleich Null invertierbar ist.[64] Matrizen über Superringen werden Supermatrizen genannt.[65]

Matrizen haben nicht immer alle Einträge im selben Ring – oder überhaupt in einem Ring. Ein besonderer, aber häufiger Fall sind Blockmatrizen, die als Matrizen betrachtet werden können, deren Einträge selbst Matrizen sind. Die Einträge müssen keine quadratischen Matrizen sein und müssen daher keine Mitglieder eines Rings sein. Ihre Größen müssen jedoch bestimmte Kompatibilitätsbedingungen erfüllen.

Beziehung zu linearen Karten[edit]

Lineare Karten R.n → R.m sind gleichbedeutend mit m-durch-n Matrizen, wie oben beschrieben. Im Allgemeinen jede lineare Karte f:: V. → W. zwischen endlichdimensionalen Vektorräumen kann durch eine Matrix beschrieben werden EIN = (einij), nach Auswahl der Basen v1, …, vn von V., und w1, …, wm von W. (damit n ist die Dimension von V. und m ist die Dimension von W.), was so ist, dass

Mit anderen Worten, Spalte j von EIN drückt das Bild von aus vj in Bezug auf die Basisvektoren wich von W.;; Somit bestimmt diese Beziehung eindeutig die Einträge der Matrix EIN. Die Matrix hängt von der Wahl der Basen ab: Unterschiedliche Basenwahlen führen zu unterschiedlichen, aber äquivalenten Matrizen.[66] Viele der oben genannten konkreten Begriffe können in diesem Licht neu interpretiert werden, beispielsweise die Transponierungsmatrix EINT. beschreibt die Transponierung der linearen Karte durch EINin Bezug auf die Doppelbasen.[67]

Diese Eigenschaften können auf natürlichere Weise angepasst werden: Die Kategorie aller Matrizen mit Einträgen in einem Feld

mit Multiplikation als Zusammensetzung entspricht der Kategorie der endlichen dimensionalen Vektorräume und linearen Karten über diesem Feld.

Im Allgemeinen ist die Menge von m×n Matrizen können verwendet werden, um die darzustellen R.-lineare Karten zwischen den freien Modulen R.m und R.n für einen beliebigen Ring R. mit der Einheit. Wann n = m Die Zusammensetzung dieser Karten ist möglich, und dies führt zum Matrixring von n×n Matrizen, die den Endomorphismusring von darstellen R.n.

Matrixgruppen[edit]

Eine Gruppe ist eine mathematische Struktur, die aus einer Menge von Objekten zusammen mit einer binären Operation besteht, dh einer Operation, bei der zwei beliebige Objekte unter bestimmten Anforderungen zu einem dritten kombiniert werden.[68] Eine Gruppe, in der die Objekte Matrizen sind und die Gruppenoperation eine Matrixmultiplikation ist, wird als a bezeichnet Matrixgruppe.[69][70] Da in einer Gruppe jedes Element invertierbar sein muss, sind die allgemeinsten Matrixgruppen die Gruppen aller invertierbaren Matrizen einer bestimmten Größe, die als allgemeine lineare Gruppen bezeichnet werden.

Jede Eigenschaft von Matrizen, die unter Matrixprodukten und Inversen erhalten bleibt, kann verwendet werden, um weitere Matrixgruppen zu definieren. Zum Beispiel bilden Matrizen mit einer gegebenen Größe und einer Determinante von 1 eine Untergruppe (dh eine kleinere Gruppe, die darin enthalten ist) ihrer allgemeinen linearen Gruppe, die als spezielle lineare Gruppe bezeichnet wird.[71]Orthogonale Matrizen, bestimmt durch die Bedingung

- M.T.M. = ich,

bilden die orthogonale Gruppe.[72] Jede orthogonale Matrix hat die Determinante 1 oder -1. Orthogonale Matrizen mit Determinante 1 bilden eine Untergruppe namens spezielle orthogonale Gruppe.

Jede endliche Gruppe ist isomorph zu einer Matrixgruppe, wie man an der regelmäßigen Darstellung der symmetrischen Gruppe sehen kann.[73] Allgemeine Gruppen können mit Hilfe von Darstellungstheorien untersucht werden, die mit Hilfe der Darstellungstheorie vergleichsweise gut verstanden werden.[74]

Unendliche Matrizen[edit]

Es ist auch möglich, Matrizen mit unendlich vielen Zeilen und / oder Spalten zu berücksichtigen[75] Selbst wenn man als unendliche Objekte solche Matrizen nicht explizit aufschreiben kann. Alles, was zählt, ist, dass für jedes Element in den Satzindizierungszeilen und für jedes Element in den Satzindizierungsspalten ein genau definierter Eintrag vorhanden ist (diese Indexsätze müssen nicht einmal Teilmengen der natürlichen Zahlen sein). Die Grundoperationen Addition, Subtraktion, Skalarmultiplikation und Transposition können weiterhin problemlos definiert werden. Die Matrixmultiplikation kann jedoch unendliche Summierungen umfassen, um die resultierenden Einträge zu definieren, und diese sind im Allgemeinen nicht definiert.

Wenn R. ist jeder Ring mit Einheit, dann der Ring der Endomorphismen von

als ein Recht R. Modul ist isomorph zum Ring von spaltenendliche Matrizen

deren Einträge sind indiziert von

und deren Spalten jeweils nur endlich viele Einträge ungleich Null enthalten. Die Endomorphismen von M. als links betrachtet R. Modul ergeben ein analoges Objekt, das Reihe endliche Matrizen

deren Zeilen jeweils nur endlich viele Einträge ungleich Null haben.

Wenn zur Beschreibung linearer Karten unendliche Matrizen verwendet werden, können aus folgendem Grund nur solche Matrizen verwendet werden, deren Spalten nur eine begrenzte Anzahl von Einträgen ungleich Null aufweisen. Für eine Matrix EIN eine lineare Karte zu beschreiben f:: V.→W., Basen für beide Räume müssen gewählt worden sein; Denken Sie daran, dass dies per Definition bedeutet, dass jeder Vektor im Raum eindeutig als (endliche) lineare Kombination von Basisvektoren geschrieben werden kann, so dass er als (Spalten-) Vektor geschrieben wird v von Koeffizienten nur endlich viele Einträge vich sind ungleich Null. Nun die Spalten von EIN Beschreibe die Bilder mit f von einzelnen Basisvektoren von V. auf der Grundlage von W.Dies ist nur dann sinnvoll, wenn diese Spalten nur endlich viele Einträge ungleich Null enthalten. Es gibt keine Einschränkung für die Zeilen von EIN jedoch: im Produkt EIN· ·v es gibt nur endlich viele Nicht-Null-Koeffizienten von v beteiligt, so dass jeder seiner Einträge, selbst wenn er als unendliche Summe von Produkten angegeben wird, nur endlich viele Nicht-Null-Begriffe enthält und daher gut definiert ist. Darüber hinaus läuft dies darauf hinaus, eine lineare Kombination der Spalten von zu bilden EIN das betrifft effektiv nur endlich viele von ihnen, von denen das Ergebnis nur endlich viele Einträge ungleich Null hat, weil jede dieser Spalten dies tut. Produkte von zwei Matrizen des angegebenen Typs sind gut definiert (vorausgesetzt, die Spaltenindex- und Zeilenindexsätze stimmen überein), sind vom gleichen Typ und entsprechen der Zusammensetzung linearer Karten.

Wenn R. ist ein normierter Ring, dann kann der Zustand der Zeilen- oder Spaltenendlichkeit gelockert werden. Mit der Norm können absolut konvergente Reihen anstelle endlicher Summen verwendet werden. Beispielsweise bilden die Matrizen, deren Spaltensummen absolut konvergente Sequenzen sind, einen Ring. Analog bilden auch die Matrizen, deren Zeilensummen absolut konvergente Reihen sind, einen Ring.

Unendliche Matrizen können auch verwendet werden, um Operatoren in Hilbert-Räumen zu beschreiben, in denen Konvergenz- und Kontinuitätsfragen auftreten, was wiederum zu bestimmten Einschränkungen führt, die auferlegt werden müssen. Der explizite Standpunkt von Matrizen tendiert jedoch dazu, die Angelegenheit zu verschleiern.[76] Stattdessen können die abstrakten und leistungsfähigeren Werkzeuge der Funktionsanalyse verwendet werden.

Leere Matrizen[edit]

Ein leere Matrix ist eine Matrix, in der die Anzahl der Zeilen oder Spalten (oder beider) Null ist.[77][78] Leere Matrizen helfen beim Umgang mit Karten, die den Nullvektorraum betreffen. Zum Beispiel, wenn EIN ist eine 3-mal-0-Matrix und B. ist also eine 0-mal-3-Matrix AB ist die 3-mal-3-Nullmatrix, die der Nullkarte aus einem dreidimensionalen Raum entspricht V. zu sich selbst, während BA ist eine 0-mal-0-Matrix. Es gibt keine übliche Notation für leere Matrizen, aber die meisten Computeralgebrasysteme ermöglichen das Erstellen und Rechnen mit diesen. Die Determinante der 0-mal-0-Matrix ist 1, wenn man das in der Leibniz-Formel für die Determinante vorkommende leere Produkt als 1 betrachtet. Dieser Wert stimmt auch mit der Tatsache überein, dass die Identitätskarte von einem endlichen dimensionalen Raum zu sich selbst hat bestimmend 1, eine Tatsache, die häufig als Teil der Charakterisierung von Determinanten verwendet wird.

Anwendungen[edit]

Es gibt zahlreiche Anwendungen von Matrizen, sowohl in der Mathematik als auch in anderen Wissenschaften. Einige von ihnen nutzen lediglich die kompakte Darstellung einer Reihe von Zahlen in einer Matrix. In der Spieltheorie und -ökonomie codiert die Auszahlungsmatrix beispielsweise die Auszahlung für zwei Spieler, je nachdem, welche aus einer gegebenen (endlichen) Menge von Alternativen die Spieler wählen.[79]Text Mining und automatisierte Thesaurus-Kompilierung verwenden Dokument-Term-Matrizen wie tf-idf, um die Häufigkeit bestimmter Wörter in mehreren Dokumenten zu verfolgen.[80]

Komplexe Zahlen können durch bestimmte reelle 2-mal-2-Matrizen über dargestellt werden

unter denen Addition und Multiplikation komplexer Zahlen und Matrizen einander entsprechen. Zum Beispiel repräsentieren 2-mal-2-Rotationsmatrizen die Multiplikation mit einer komplexen Anzahl von Absolutwerten 1 wie oben. Eine ähnliche Interpretation ist für Quaternionen möglich[81] und Clifford-Algebren im Allgemeinen.

Frühe Verschlüsselungstechniken wie die Hill-Chiffre verwendeten ebenfalls Matrizen. Aufgrund der linearen Natur von Matrizen sind diese Codes jedoch vergleichsweise leicht zu brechen.[82]Computergrafik verwendet Matrizen sowohl zur Darstellung von Objekten als auch zur Berechnung von Transformationen von Objekten unter Verwendung affiner Rotationsmatrizen, um Aufgaben wie das Projizieren eines dreidimensionalen Objekts auf einen zweidimensionalen Bildschirm entsprechend einer theoretischen Kamerabeobachtung auszuführen.[83] Matrizen über einem Polynomring sind wichtig für das Studium der Kontrolltheorie.

Die Chemie nutzt Matrizen auf verschiedene Weise, insbesondere seit der Verwendung der Quantentheorie zur Diskussion molekularer Bindungen und Spektroskopie. Beispiele sind die Überlappungsmatrix und die Fock-Matrix, die zur Lösung der Roothaan-Gleichungen verwendet werden, um die Molekülorbitale der Hartree-Fock-Methode zu erhalten.

Graphentheorie[edit]

Die Adjazenzmatrix eines endlichen Graphen ist ein Grundbegriff der Graphentheorie.[84] Es wird aufgezeichnet, welche Eckpunkte des Diagramms durch eine Kante verbunden sind. Matrizen, die nur zwei verschiedene Werte enthalten (1 und 0 bedeuten beispielsweise “Ja” bzw. “Nein”), werden als logische Matrizen bezeichnet. Die Abstands- (oder Kosten-) Matrix enthält Informationen über Abstände der Kanten.[85] Diese Konzepte können auf Websites angewendet werden, die durch Hyperlinks oder Städte verbunden sind, die durch Straßen usw. verbunden sind. In diesem Fall (sofern das Verbindungsnetzwerk nicht extrem dicht ist) sind die Matrizen in der Regel spärlich, dh sie enthalten nur wenige Einträge ungleich Null. Daher können in der Netzwerktheorie speziell zugeschnittene Matrixalgorithmen verwendet werden.

Analyse und Geometrie[edit]

Die hessische Matrix einer differenzierbaren Funktion ƒ:: R.n → R. besteht aus den zweiten Ableitungen von ƒ in Bezug auf die verschiedenen Koordinatenrichtungen, d. h.[86]

Es codiert Informationen über das lokale Wachstumsverhalten der Funktion: an einem kritischen Punkt x = ((x1, …, xn), dh ein Punkt, an dem die ersten partiellen Ableitungen

von ƒ verschwinden, die Funktion hat ein lokales Minimum, wenn die hessische Matrix positiv definit ist. Die quadratische Programmierung kann verwendet werden, um globale Minima oder Maxima quadratischer Funktionen zu finden, die eng mit denen verwandt sind, die an Matrizen gebunden sind (siehe oben).[87]

Eine andere Matrix, die häufig in geometrischen Situationen verwendet wird, ist die Jacobi-Matrix einer differenzierbaren Karte f:: R.n → R.m. Wenn f1, …, fm bezeichnen die Komponenten von fdann ist die Jacobi-Matrix definiert als[88]

Wenn n > mund wenn der Rang der Jacobi-Matrix seinen Maximalwert erreicht m, f ist an diesem Punkt durch den impliziten Funktionssatz lokal invertierbar.[89]

Partielle Differentialgleichungen können klassifiziert werden, indem die Koeffizientenmatrix der Differentialoperatoren höchster Ordnung der Gleichung berücksichtigt wird. Für elliptische partielle Differentialgleichungen ist diese Matrix positiv definit, was einen entscheidenden Einfluss auf die Menge möglicher Lösungen der fraglichen Gleichung hat.[90]

Die Finite-Elemente-Methode ist eine wichtige numerische Methode zur Lösung partieller Differentialgleichungen, die bei der Simulation komplexer physikalischer Systeme weit verbreitet ist. Es wird versucht, die Lösung einer Gleichung durch stückweise lineare Funktionen zu approximieren, wobei die Teile in Bezug auf ein ausreichend feines Gitter ausgewählt werden, das wiederum als Matrixgleichung neu gefasst werden kann.[91]

Wahrscheinlichkeitstheorie und Statistik[edit]

Stochastische Matrizen sind quadratische Matrizen, deren Zeilen Wahrscheinlichkeitsvektoren sind, dh deren Einträge nicht negativ sind und sich zu eins summieren. Stochastische Matrizen werden verwendet, um Markov-Ketten mit endlich vielen Zuständen zu definieren.[92] Eine Zeile der stochastischen Matrix gibt die Wahrscheinlichkeitsverteilung für die nächste Position eines Partikels an, das sich derzeit in dem Zustand befindet, der der Zeile entspricht. Eigenschaften der Markov-Kette wie absorbierende Zustände, dh Zustände, die jedes Teilchen schließlich erreicht, können von den Eigenvektoren der Übergangsmatrizen abgelesen werden.[93]

Die Statistik verwendet auch Matrizen in vielen verschiedenen Formen.[94]Die deskriptive Statistik befasst sich mit der Beschreibung von Datensätzen, die häufig als Datenmatrizen dargestellt werden können, die dann Techniken zur Reduzierung der Dimensionalität unterzogen werden können. Die Kovarianzmatrix codiert die gegenseitige Varianz mehrerer Zufallsvariablen.[95] Eine andere Technik, die Matrizen verwendet, sind lineare kleinste Quadrate, eine Methode, die sich einer endlichen Menge von Paaren annähert (x1, y1), (x2, y2), …, (xN., yN.) durch eine lineare Funktion

- yich ≈ Axtich + b, ich = 1, …, N.

die in Form von Matrizen formuliert werden können, bezogen auf die Singularwertzerlegung von Matrizen.[96]

Zufallsmatrizen sind Matrizen, deren Einträge Zufallszahlen sind, vorbehaltlich geeigneter Wahrscheinlichkeitsverteilungen, wie z. B. der Matrixnormalverteilung. Über die Wahrscheinlichkeitstheorie hinaus werden sie in Bereichen von der Zahlentheorie bis zur Physik angewendet.[97][98]

Symmetrien und Transformationen in der Physik[edit]

Lineare Transformationen und die damit verbundenen Symmetrien spielen in der modernen Physik eine Schlüsselrolle. Beispielsweise werden Elementarteilchen in der Quantenfeldtheorie als Darstellungen der Lorentz-Gruppe der speziellen Relativitätstheorie und insbesondere aufgrund ihres Verhaltens unter der Spingruppe klassifiziert. Konkrete Darstellungen der Pauli-Matrizen und allgemeinerer Gammamatrizen sind ein wesentlicher Bestandteil der physikalischen Beschreibung von Fermionen, die sich wie Spinoren verhalten.[99] Für die drei leichtesten Quarks gibt es eine gruppentheoretische Darstellung der speziellen Einheitsgruppe SU (3); Für ihre Berechnungen verwenden Physiker eine bequeme Matrixdarstellung, die als Gell-Mann-Matrizen bekannt ist und auch für die SU (3) -Gerätgruppe verwendet wird, die die Grundlage für die moderne Beschreibung starker Kernwechselwirkungen, die Quantenchromodynamik, bildet. Die Cabibbo-Kobayashi-Maskawa-Matrix drückt wiederum die Tatsache aus, dass die für schwache Wechselwirkungen wichtigen Quark-Grundzustände nicht dieselben sind, sondern linear mit den Quark-Grundzuständen zusammenhängen, die Partikel mit spezifischen und unterschiedlichen Massen definieren.[100]

Lineare Kombinationen von Quantenzuständen[edit]

Das erste Modell der Quantenmechanik (Heisenberg, 1925) stellte die Operatoren der Theorie durch unendlich dimensionale Matrizen dar, die auf Quantenzustände einwirken.[101] Dies wird auch als Matrixmechanik bezeichnet. Ein besonderes Beispiel ist die Dichtematrix, die den “gemischten” Zustand eines Quantensystems als eine lineare Kombination von elementaren “reinen” Eigenzuständen charakterisiert.[102]

Eine andere Matrix dient als Schlüsselwerkzeug zur Beschreibung der Streuexperimente, die den Eckpfeiler der experimentellen Teilchenphysik bilden: Kollisionsreaktionen, wie sie in Teilchenbeschleunigern auftreten, bei denen nicht wechselwirkende Teilchen aufeinander zugehen und in einer kleinen Wechselwirkungszone mit einer neuen kollidieren Ein Satz nicht wechselwirkender Partikel als Ergebnis kann als das Skalarprodukt ausgehender Partikelzustände und einer linearen Kombination eingehender Partikelzustände beschrieben werden. Die lineare Kombination wird durch eine Matrix gegeben, die als S-Matrix bekannt ist und alle Informationen über die möglichen Wechselwirkungen zwischen Partikeln codiert.[103]

Normale Modi[edit]

Eine allgemeine Anwendung von Matrizen in der Physik ist die Beschreibung linear gekoppelter harmonischer Systeme. Die Bewegungsgleichungen solcher Systeme können in Matrixform beschrieben werden, wobei eine Massenmatrix eine verallgemeinerte Geschwindigkeit multipliziert, um den kinetischen Term zu ergeben, und eine Kraftmatrix einen Verschiebungsvektor multipliziert, um die Wechselwirkungen zu charakterisieren. Der beste Weg, um Lösungen zu erhalten, besteht darin, die Eigenvektoren des Systems, seine Normalmoden, durch Diagonalisierung der Matrixgleichung zu bestimmen. Techniken wie diese sind entscheidend für die innere Dynamik von Molekülen: die inneren Schwingungen von Systemen, die aus miteinander verbundenen Komponentenatomen bestehen.[104] Sie werden auch zur Beschreibung mechanischer Schwingungen und Schwingungen in elektrischen Schaltkreisen benötigt.[105]

Geometrische Optik[edit]

Die geometrische Optik bietet weitere Matrixanwendungen. In dieser Näherungstheorie wird die Wellennatur des Lichts vernachlässigt. Das Ergebnis ist ein Modell, bei dem Lichtstrahlen tatsächlich geometrische Strahlen sind. Wenn die Ablenkung von Lichtstrahlen durch optische Elemente gering ist, kann die Wirkung einer Linse oder eines reflektierenden Elements auf einen bestimmten Lichtstrahl als Multiplikation eines Zweikomponentenvektors mit einer Zwei-mal-Zwei-Matrix ausgedrückt werden, die als Strahlentransfermatrixanalyse bezeichnet wird: Die Komponenten des Vektors sind die Steigung des Lichtstrahls und sein Abstand von der optischen Achse, während die Matrix die Eigenschaften des optischen Elements codiert. Tatsächlich gibt es zwei Arten von Matrizen, nämlich. ein Brechungsmatrix Beschreibung der Brechung an einer Linsenoberfläche und a Übersetzungsmatrixund beschreibt die Verschiebung der Bezugsebene zur nächsten Brechungsfläche, für die eine andere Brechungsmatrix gilt. Das optische System, das aus einer Kombination von Linsen und / oder reflektierenden Elementen besteht, wird einfach durch die Matrix beschrieben, die sich aus dem Produkt der Matrizen der Komponenten ergibt.[106]

Elektronik[edit]

Die traditionelle Netzanalyse und Knotenanalyse in der Elektronik führt zu einem linearen Gleichungssystem, das mit einer Matrix beschrieben werden kann.

Das Verhalten vieler elektronischer Komponenten kann mithilfe von Matrizen beschrieben werden. Lassen EIN ein zweidimensionaler Vektor mit der Eingangsspannung der Komponente sein v1 und Eingangsstrom ich1 als seine Elemente und lassen B. ein zweidimensionaler Vektor mit der Ausgangsspannung der Komponente sein v2 und Ausgangsstrom ich2 als seine Elemente. Dann kann das Verhalten der elektronischen Komponente durch beschrieben werden B. = H. · · EIN, wo H. ist eine 2 x 2-Matrix, die ein Impedanzelement enthält (h12), ein Zulassungselement (h21) und zwei dimensionslose Elemente (h11 und h22). Die Berechnung einer Schaltung reduziert sich nun auf die Multiplikation von Matrizen.

Geschichte[edit]

Matrizen haben eine lange Tradition in der Lösung linearer Gleichungen, wurden jedoch bis ins 19. Jahrhundert als Arrays bezeichnet. Der chinesische Text Die neun Kapitel zur mathematischen Kunst geschrieben im 10. – 2. Jahrhundert v. Chr. ist das erste Beispiel für die Verwendung von Array-Methoden zur Lösung simultaner Gleichungen.[107] einschließlich des Konzepts der Determinanten. 1545 brachte der italienische Mathematiker Gerolamo Cardano die Methode bei seiner Veröffentlichung nach Europa Ars Magna.[108] Der japanische Mathematiker Seki verwendete 1683 die gleichen Array-Methoden, um simultane Gleichungen zu lösen.[109] Der niederländische Mathematiker Jan de Witt stellte in seinem Buch von 1659 Transformationen mit Arrays dar Elemente von Kurven (1659).[110] Zwischen 1700 und 1710 veröffentlichte Gottfried Wilhelm Leibniz die Verwendung von Arrays zur Aufzeichnung von Informationen oder Lösungen und experimentierte mit über 50 verschiedenen Arraysystemen.[108]Cramer stellte seine Herrschaft 1750 vor.

Der Begriff “Matrix” (lateinisch für “Mutterleib”, abgeleitet von mater-Mutter[111]) wurde 1850 von James Joseph Sylvester geprägt,[112] die eine Matrix als ein Objekt verstanden haben, aus dem heute eine Reihe von Determinanten hervorgehen, die als Minderjährige bezeichnet werden, dh Determinanten kleinerer Matrizen, die durch Entfernen von Spalten und Zeilen von der ursprünglichen abgeleitet werden. In einem Artikel von 1851 erklärt Sylvester:

- Ich habe in früheren Arbeiten eine “Matrix” als eine rechteckige Anordnung von Begriffen definiert, aus denen verschiedene Determinantensysteme wie aus dem Mutterleib eines gemeinsamen Elternteils erzeugt werden können.[113]

Arthur Cayley veröffentlichte eine Abhandlung über geometrische Transformationen unter Verwendung von Matrizen, die keine gedrehten Versionen der untersuchten Koeffizienten waren, wie dies zuvor getan worden war. Stattdessen definierte er Operationen wie Addition, Subtraktion, Multiplikation und Division als Transformationen dieser Matrizen und zeigte, dass die assoziativen und verteilenden Eigenschaften wahr sind. Cayley untersuchte und demonstrierte die nichtkommutative Eigenschaft der Matrixmultiplikation sowie die kommutative Eigenschaft der Matrixaddition.[108] Die frühe Matrixtheorie hatte die Verwendung von Arrays fast ausschließlich auf Determinanten beschränkt, und Arthur Cayleys abstrakte Matrixoperationen waren revolutionär. Er war maßgeblich daran beteiligt, ein von Gleichungssystemen unabhängiges Matrixkonzept vorzuschlagen. 1858 veröffentlichte Cayley seine Eine Abhandlung über die Theorie der Matrizen[114][115] in dem er den Cayley-Hamilton-Satz vorschlug und demonstrierte.[108]

Ein englischer Mathematiker namens Cullis war der erste, der 1913 die moderne Klammernotation für Matrizen verwendete, und er demonstrierte gleichzeitig die erste signifikante Verwendung der Notation EIN = [ai,j] eine Matrix darstellen, wo einich,j bezieht sich auf ichth Reihe und die jth Spalte.[108]

Die moderne Untersuchung von Determinanten entsprang mehreren Quellen.[116]Zahlentheoretische Probleme führten dazu, dass Gauß Koeffizienten quadratischer Formen in Beziehung setzte, dh Ausdrücke wie x2 + xy – 2y2, und lineare Karten in drei Dimensionen auf Matrizen. Eisenstein hat diese Begriffe weiterentwickelt, einschließlich der Bemerkung, dass Matrixprodukte im modernen Sprachgebrauch nicht kommutativ sind. Cauchy war der erste, der allgemeine Aussagen über Determinanten unter Verwendung der Definition der Determinante einer Matrix bewies EIN = [ai,j] Folgendes: Ersetzen Sie die Kräfte einjk durch einjk im Polynom

- ,

wobei Π das Produkt der angegebenen Begriffe bezeichnet. Er zeigte 1829 auch, dass die Eigenwerte symmetrischer Matrizen real sind.[117]Jacobi untersuchte “funktionelle Determinanten” – später von Sylvester Jacobi-Determinanten genannt -, mit denen geometrische Transformationen auf lokaler (oder infinitesimaler) Ebene beschrieben werden können, siehe oben; Kronecker Vorlesungen über die Theorie der Determinanten[118] und Weierstrass ‘ Zur Determinantentheorie,[119] beide 1903 veröffentlicht, behandelten Determinanten zuerst axiomatisch, im Gegensatz zu früheren konkreteren Ansätzen wie der erwähnten Formel von Cauchy. Zu diesem Zeitpunkt waren Determinanten fest etabliert.

Viele Theoreme wurden zuerst nur für kleine Matrizen aufgestellt, zum Beispiel wurde das Cayley-Hamilton-Theorem von Cayley in den oben genannten Memoiren für 2 × 2-Matrizen und von Hamilton für 4 × 4-Matrizen bewiesen. Frobenius, der an bilinearen Formen arbeitete, verallgemeinerte den Satz auf alle Dimensionen (1898). Ebenfalls Ende des 19. Jahrhunderts wurde von Jordanien die Gauß-Jordan-Eliminierung (die einen Sonderfall verallgemeinert, der jetzt als Gauß-Eliminierung bekannt ist) eingeführt. Im frühen 20. Jahrhundert erlangten Matrizen eine zentrale Rolle in der linearen Algebra.[120] teilweise aufgrund ihrer Verwendung bei der Klassifizierung der hyperkomplexen Zahlensysteme des vorigen Jahrhunderts.

Die Einführung der Matrixmechanik durch Heisenberg, Born und Jordan führte zur Untersuchung von Matrizen mit unendlich vielen Zeilen und Spalten.[121] Später führte von Neumann die mathematische Formulierung der Quantenmechanik durch, indem er funktionale analytische Begriffe wie lineare Operatoren auf Hilbert-Räumen weiterentwickelte, die grob gesagt dem euklidischen Raum entsprechen, jedoch unendlich viele unabhängige Richtungen aufweisen.

Andere historische Verwendungen des Wortes “Matrix” in der Mathematik[edit]

Das Wort wurde auf ungewöhnliche Weise von mindestens zwei Autoren von historischer Bedeutung verwendet.

Bertrand Russell und Alfred North Whitehead in ihrem Principia Mathematica (1910–1913) verwenden das Wort “Matrix” im Kontext ihres Axioms der Reduzierbarkeit. Sie schlugen dieses Axiom vor, um eine Funktion nacheinander auf eine Funktion niedrigeren Typs zu reduzieren, so dass die Funktion im “unteren Bereich” (Ordnung 0) mit ihrer Erweiterung identisch ist:

- “Geben wir den Namen an Matrix für jede Funktion, wie viele Variablen auch immer, die keine offensichtlichen Variablen beinhaltet. Dann leitet sich jede mögliche andere Funktion als eine Matrix durch Verallgemeinerung aus einer Matrix ab, dh unter Berücksichtigung des Satzes, dass die fragliche Funktion mit allen möglichen Werten oder mit einem Wert eines der Argumente, des anderen Arguments oder wahr ist Argumente bleiben unbestimmt “.[122]

Zum Beispiel eine Funktion Φ (x, y) von zwei Variablen x und y kann auf a reduziert werden Sammlung von Funktionen einer einzelnen Variablen, zum Beispiel, ydurch “Betrachten” der Funktion für alle möglichen Werte von “Individuen” einich anstelle der Variablen ersetzt x. Und dann die resultierende Sammlung von Funktionen der einzelnen Variablen ydas heißt, ∀aich: Φ (einichy) kann auf eine “Matrix” von Werten reduziert werden, indem die Funktion für alle möglichen Werte von “Individuen” “berücksichtigt” wird. bich anstelle der Variablen ersetzt y::

- ∀bj∀aich: Φ (einich, bj).

Alfred Tarski in seinem 1946 Einführung in die Logik benutzte das Wort “Matrix” synonym mit dem Begriff der Wahrheitstabelle, wie er in der mathematischen Logik verwendet wird.[123]

Siehe auch[edit]

- ^ Anton (1987, S. 23)

- ^ Beauregard & Fraleigh (1973, S. 56)

- ^ ein b c “Umfassende Liste der Algebra-Symbole”. Math Vault. 2020-03-25. Abgerufen 2020-08-19.

- ^ Jung, Cynthia. Precalculus. Laurie Rosatone. p. 727.

- ^ “Matrizen”. www.mathsisfun.com. Abgerufen 2020-08-19.

- ^ ein b “Matrix | Mathematik”. Enzyklopädie Britannica. Abgerufen 2020-08-19.

- ^ K. Bryan und T. Leise. Der $ 25.000.000.000 Eigenvektor: Die lineare Algebra hinter Google. SIAM Review, 48 (3): 569–581, 2006.

- ^ Lang 2002

- ^ Fraleigh (1976, S. 209)

- ^ Nering (1970, S. 37)

- ^ ein b Weisstein, Eric W. “Matrix”. mathworld.wolfram.com. Abgerufen 2020-08-19.

- ^ Oualline 2003, Ch. 5

- ^ “Wie man Matrizen organisiert, hinzufügt und multipliziert – Bill Shillito”. TED ED. Abgerufen 6. April 2013.

- ^ Brown 1991, Definition I.2.1 (Addition), Definition I.2.4 (Skalarmultiplikation) und Definition I.2.33 (Transponierung)

- ^ Brown 1991, Satz I.2.6

- ^ ein b “Wie man Matrizen multipliziert”. www.mathsisfun.com. Abgerufen 2020-08-19.

- ^ Brown 1991, Definition I.2.20

- ^ Brown 1991, Satz I.2.24

- ^ Horn & Johnson 1985, Ch. 4 und 5

- ^ Bronson (1970, S. 16)

- ^ Kreyszig (1972, S. 220)

- ^ ein b Protter & Morrey (1970, S. 869)

- ^ Kreyszig (1972, S. 241, 244)

- ^ Schneider, Hans; Barker, George Phillip (2012), Matrizen und lineare Algebra, Dover Bücher über Mathematik, Courier Dover Corporation, p. 251, ISBN 9780486139302.

- ^ Perlis, Sam (1991), Theorie der Matrizen, Dover Bücher über fortgeschrittene Mathematik, Courier Dover Corporation, p. 103, ISBN 9780486668109.

- ^ Anton, Howard (2010), Elementare lineare Algebra (10. Aufl.), John Wiley & Sons, p. 414, ISBN 9780470458211.

- ^ Horn, Roger A.; Johnson, Charles R. (2012), Matrixanalyse (2. Aufl.), Cambridge University Press, p. 17, ISBN 9780521839402.

- ^ Brown 1991, I.2.21 und 22

- ^ Greub 1975, Abschnitt III.2

- ^ Brown 1991, Definition II.3.3

- ^ Greub 1975, Abschnitt III.1

- ^ Brown 1991, Satz II.3.22

- ^ Horn & Johnson 1985, Satz 2.5.6

- ^ Brown 1991, Definition I.2.28

- ^ Brown 1991, Definition I.5.13

- ^ Horn & Johnson 1985, Kapitel 7

- ^ Horn & Johnson 1985, Satz 7.2.1

- ^ Horn & Johnson 1985, Beispiel 4.0.6, p. 169

- ^ Brown 1991, Definition III.2.1

- ^ Brown 1991, Satz III.2.12

- ^ Brown 1991, Folgerung III.2.16

- ^ Mirsky 1990, Satz 1.4.1

- ^ Brown 1991, Satz III.3.18

- ^ Eigen bedeutet auf Deutsch und Niederländisch “besitzen”.

- ^ Brown 1991, Definition III.4.1

- ^ Brown 1991, Definition III.4.9

- ^ Brown 1991, Folgerung III.4.10

- ^ Haushaltsvorstand 1975, Kap. 7

- ^ Bau III & Trefethen 1997

- ^ Golub & Van Loan 1996, Algorithmus 1.3.1

- ^ Golub & Van Loan 1996, Kapitel 9 und 10, insb. Abschnitt 10.2

- ^ Golub & Van Loan 1996, Kapitel 2.3

- ^ Grcar, Joseph F. (01.01.2011). “John von Neumanns Analyse der Gaußschen Eliminierung und die Ursprünge der modernen numerischen Analyse”. SIAM Review. 53 (4): 607–682. doi:10.1137 / 080734716. ISSN 0036-1445.

- ^ Zum Beispiel Mathematica, siehe Wolfram 2003, Kap. 3.7

- ^ Press, Flannery & Teukolsky 1992

- ^ Stoer & Bulirsch 2002, Abschnitt 4.1

- ^ Horn & Johnson 1985, Satz 2.5.4

- ^ Horn & Johnson 1985, Ch. 3.1, 3.2

- ^ Arnold & Cooke 1992, Abschnitte 14.5, 7, 8

- ^ Bronson 1989, Ch. 15

- ^ Coburn 1955, Ch. V.

- ^ Lang 2002, Kapitel XIII

- ^ Lang 2002, XVII.1, p. 643

- ^ Lang 2002, Proposition XIII.4.16

- ^ Reichl 2004, Abschnitt L.2

- ^ Greub 1975, Abschnitt III.3

- ^ Greub 1975, Abschnitt III.3.13

- ^ Siehe alle Standardreferenzen in der Gruppe.

- ^ Zusätzlich muss die Gruppe in der allgemeinen linearen Gruppe geschlossen sein.

- ^ Baker 2003, Def. 1.30

- ^ Baker 2003, Satz 1.2

- ^ Artin 1991, Kapitel 4.5

- ^ Rowen 2008, Beispiel 19.2, p. 198

- ^ Siehe jede Referenz in der Darstellungstheorie oder Gruppendarstellung.

- ^ Siehe den Punkt “Matrix” in Itõ, hrsg. 1987

- ^ “Nicht viel von der Matrixtheorie überträgt sich auf unendlich dimensionale Räume, und was das tut, ist nicht so nützlich, aber es hilft manchmal.” Halmos 1982, p. 23, Kapitel 5

- ^ “Leere Matrix: Eine Matrix ist leer, wenn ihre Zeilen- oder Spaltenabmessung Null ist”, Glossar Archiviert 2009-04-29 im Wayback Machine, O-Matrix v6 Benutzerhandbuch

- ^ “Eine Matrix mit mindestens einer Dimension gleich Null wird als leere Matrix bezeichnet”, MATLAB-Datenstrukturen Archiviert 28.12.2009 an der Wayback-Maschine

- ^ Fudenberg & Tirole 1983, Abschnitt 1.1.1

- ^ Manning 1999, Abschnitt 15.3.4

- ^ Ward 1997, Ch. 2.8

- ^ Stinson 2005, Ch. 1.1.5 und 1.2.4

- ^ Verein für Computermaschinen 1979, Kap. 7

- ^ Godsil & Royle 2004, Kap. 8.1

- ^ Punnen 2002

- ^ Lang 1987a, Ch. XVI.6

- ^ Nocedal 2006, Kap. 16

- ^ Lang 1987a, Ch. XVI.1

- ^ Lang 1987a, Ch. XVI.5. Für eine fortgeschrittenere und allgemeinere Aussage siehe Lang 1969, Kap. VI.2

- ^ Gilbarg & Trudinger 2001

- ^ Šolin 2005, Kap. 2.5. Siehe auch Steifheitsmethode.

- ^ Latouche & Ramaswami 1999

- ^ Mehata & Srinivasan 1978, Ch. 2.8

- ^ Healy, Michael (1986), Matrizen für die Statistik, Oxford University Press, ISBN 978-0-19-850702-4

- ^ Krzanowski 1988, Ch. 2.2., P. 60

- ^ Krzanowski 1988, Ch. 4.1

- ^ Conrey 2007

- ^ Zabrodin, Brezin & amp; Kazakov et al. 2006

- ^ Itzykson & Zuber 1980, Ch. 2

- ^ siehe Burgess & Moore 2007, Abschnitt 1.6.3. (SU (3)), Abschnitt 2.4.3.2. (Kobayashi-Maskawa-Matrix)

- ^ Schiff 1968, Ch. 6

- ^ Bohm 2001, Abschnitte II.4 und II.8

- ^ Weinberg 1995, Ch. 3

- ^ Wherrett 1987, Teil II

- ^ Riley, Hobson & Bence 1997, 7.17

- ^ Günther 1990, Kap. 5

- ^ Shen, Crossley & Lun 1999, zitiert von Bretscher 2005, p. 1

- ^ ein b c d e Diskrete Mathematik 4th Ed. Dossey, Otto, Spense, Vanden Eynden, Herausgegeben von Addison Wesley, 10. Oktober 2001 ISBN 978-0321079121, p. 564-565

- ^ Needham, Joseph; Wang Ling (1959). Wissenschaft und Zivilisation in China. III. Cambridge: Cambridge University Press. p. 117. ISBN 9780521058018.

- ^ Diskrete Mathematik 4th Ed. Dossey, Otto, Spense, Vanden Eynden, Herausgegeben von Addison Wesley, 10. Oktober 2001 ISBN 978-0321079121, p. 564

- ^ Merriam-Webster-Wörterbuch, Merriam-Websterabgerufen 20. April 2009

- ^ Obwohl viele Quellen behaupten, dass JJ Sylvester 1848 den mathematischen Begriff “Matrix” geprägt hat, veröffentlichte Sylvester 1848 nichts. (Zum Beweis, dass Sylvester 1848 nichts veröffentlichte, siehe: JJ Sylvester mit HF Baker, Hrsg., Die gesammelten mathematischen Papiere von James Joseph Sylvester (Cambridge, England: Cambridge University Press, 1904), vol. 1.) Seine früheste Verwendung des Begriffs “Matrix” findet 1850 in JJ Sylvester (1850) statt. Das London, Edinburgh und Dublin Philosophical Magazine und Journal of Science, 37: 363-370. Ab Seite 369: “Zu diesem Zweck müssen wir nicht mit einem Quadrat beginnen, sondern mit einer länglichen Anordnung von Begriffen, die vermutlich aus m Zeilen und n Spalten bestehen. Dies stellt an sich keine Determinante dar, sondern ist sozusagen a Matrix, aus der wir verschiedene Determinantensysteme bilden können … “

- ^ Die gesammelten mathematischen Papiere von James Joseph Sylvester: 1837–1853, Papier 37, p. 247

- ^ Phil.Trans. 1858, Bd. 148, S. 17-37 Mathematik. Aufsätze II 475-496

- ^ Dieudonné, hrsg. 1978, Vol. 1, Ch. III, p. 96

- ^ Knobloch 1994

- ^ Hawkins 1975

- ^ Kronecker 1897

- ^ Weierstrass 1915, S. 271–286

- ^ Bôcher 2004

- ^ Mehra & Rechenberg 1987

- ^ Whitehead, Alfred North; und Russell, Bertrand (1913) Principia Mathematica bis * 56, Cambridge bei der University Press, Cambridge UK (neu veröffentlicht 1962), siehe Seite 162ff.

- ^ Tarski, Alfred; (1946) Einführung in die Logik und die Methodik der deduktiven Wissenschaften, Dover Publications, Inc., New York, NY, ISBN 0-486-28462-X.

Verweise[edit]

- Anton, Howard (1987), Elementare lineare Algebra (5. Aufl.), New York: Wiley, ISBN 0-471-84819-0

- Arnold, Vladimir I.; Cooke, Roger (1992), Gewöhnliche Differentialgleichungen, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-3-540-54813-3

- Artin, Michael (1991), Algebra, Prentice Hall, ISBN 978-0-89871-510-1

- Verein für Computermaschinen (1979), Computergrafik, Tata McGraw-Hill, ISBN 978-0-07-059376-3

- Baker, Andrew J. (2003), Matrixgruppen: Eine Einführung in die Lügengruppentheorie, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-1-85233-470-3

- Bau III, David; Trefethen, Lloyd N. (1997), Numerische lineare Algebra, Philadelphia, PA: Gesellschaft für industrielle und angewandte Mathematik, ISBN 978-0-89871-361-9

- Beauregard, Raymond A.; Fraleigh, John B. (1973), Ein erster Kurs in linearer Algebra: mit optionaler Einführung in Gruppen, Ringe und Felder, Boston: Houghton Mifflin Co., ISBN 0-395-14017-X

- Bretscher, Otto (2005), Lineare Algebra mit Anwendungen (3. Aufl.), Prentice Hall

- Bronson, Richard (1970), Matrixmethoden: Eine Einführung, New York: Akademische Presse, LCCN 70097490

- Bronson, Richard (1989), Schaums Überblick über Theorie und Probleme von Matrixoperationen, New York: McGraw-Hill, ISBN 978-0-07-007978-6

- Brown, William C. (1991), Matrizen und Vektorräume, New York, NY: Marcel Dekker, ISBN 978-0-8247-8419-5

- Coburn, Nathaniel (1955), Vektor- und Tensoranalyse, New York, NY: Macmillan, OCLC 1029828

- Conrey, J. Brian (2007), Reihen elliptischer Kurven und Zufallsmatrixtheorie, Cambridge University Press, ISBN 978-0-521-69964-8

- Fraleigh, John B. (1976), Ein erster Kurs in abstrakter Algebra (2. Aufl.), Lesung: Addison-Wesley, ISBN 0-201-01984-1

- Fudenberg, Drew; Tirole, Jean (1983), Spieltheorie, MIT Press

- Gilbarg, David; Trudinger, Neil S. (2001), Elliptische partielle Differentialgleichungen zweiter Ordnung (2. Aufl.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-3-540-41160-4

- Godsil, Chris; Royle, Gordon (2004), Algebraische Graphentheorie, Diplomtexte in Mathematik, 207, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-95220-8

- Golub, Gene H.; Van Loan, Charles F. (1996), Matrixberechnungen (3. Aufl.), Johns Hopkins, ISBN 978-0-8018-5414-9

- Greub, Werner Hildbert (1975), Lineare Algebra, Diplomtexte in Mathematik, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-90110-7

- Halmos, Paul Richard (1982), Ein Hilbert-Raumproblembuch, Diplomtexte in Mathematik, 19 (2. Aufl.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-90685-0, HERR 0675952

- Horn, Roger A.; Johnson, Charles R. (1985), Matrixanalyse, Cambridge University Press, ISBN 978-0-521-38632-6

- Haushaltsvorstand, Alston S. (1975), Die Theorie der Matrizen in der numerischen Analyse, New York, NY: Dover Publications, MR 0378371

- Kreyszig, Erwin (1972), Advanced Engineering Mathematics (3. Aufl.), New York: Wiley, ISBN 0-471-50728-8.

- Krzanowski, Wojtek J. (1988), Prinzipien der multivariaten Analyse, Oxford Statistical Science Series, 3, Die Clarendon Press Oxford University Press, ISBN 978-0-19-852211-9, HERR 0969370

- Itô, Kiyosi, hrsg. (1987), Enzyklopädisches Wörterbuch der Mathematik. Vol. I-IV (2. Aufl.), MIT Press, ISBN 978-0-262-09026-1, HERR 0901762

- Lang, Serge (1969), Analyse II, Addison-Wesley

- Lang, Serge (1987a), Berechnung mehrerer Variablen (3. Aufl.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-96405-8

- Lang, Serge (1987b), Lineare Algebra, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-96412-6

- Lang, Serge (2002), Algebra, Diplomtexte in Mathematik, 211 (Überarbeitete dritte Ausgabe), New York: Springer-Verlag, ISBN 978-0-387-95385-4, HERR 1878556

- Latouche, Guy; Ramaswami, Vaidyanathan (1999), Einführung in Matrixanalysemethoden in der stochastischen Modellierung (1. Aufl.), Philadelphia, PA: Gesellschaft für industrielle und angewandte Mathematik, ISBN 978-0-89871-425-8

- Manning, Christopher D.; Schütze, Hinrich (1999), Grundlagen der statistischen Verarbeitung natürlicher Sprache, MIT Press, ISBN 978-0-262-13360-9

- Mehata, KM; Srinivasan, SK (1978), Stochastische Prozesse, New York, NY: McGraw-Hill, ISBN 978-0-07-096612-3

- Mirsky, Leonid (1990), Eine Einführung in die lineare Algebra, Courier Dover Publications, ISBN 978-0-486-66434-7

- Nering, Evar D. (1970), Lineare Algebra und Matrixtheorie (2. Aufl.), New York: Wiley, LCCN 76-91646

- Nocedal, Jorge; Wright, Stephen J. (2006), Numerische Optimierung (2. Aufl.), Berlin, DE; New York, NY: Springer-Verlag, p. 449, ISBN 978-0-387-30303-1

- Oualline, Steve (2003), Praktische C ++ – Programmierung, O’Reilly, ISBN 978-0-596-00419-4

- Press, William H.; Flannery, Brian P.; Teukolsky, Saul A.; Vetterling, William T. (1992), “LU-Zersetzung und ihre Anwendungen” (PDF), Numerische Rezepte in FORTRAN: Die Kunst des wissenschaftlichen Rechnens (2. Aufl.), Cambridge University Press, S. 34–42, archiviert vom Original am 06.09.2009CS1-Wartung: nicht angepasste URL (Link)

- Protter, Murray H.; Morrey Jr., Charles B. (1970), Hochschulrechnung mit analytischer Geometrie (2. Aufl.), Lesung: Addison-Wesley, LCCN 76087042

- Punnen, Abraham P.; Gutin, Gregory (2002), Das Problem des Handlungsreisenden und seine Variationen, Boston, MA: Kluwer Academic Publishers, ISBN 978-1-4020-0664-7

- Reichl, Linda E. (2004), Der Übergang zum Chaos: konservative klassische Systeme und Quantenmanifestationen, Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-98788-0

- Rowen, Louis Halle (2008), Graduiertenalgebra: nicht kommutative Sichtweise, Providence, RI: Amerikanische Mathematische Gesellschaft, ISBN 978-0-8218-4153-2

- Šolin, Pavel (2005), Partielle Differentialgleichungen und die Finite-Elemente-Methode, Wiley-Interscience, ISBN 978-0-471-76409-0

- Stinson, Douglas R. (2005), Kryptographie, Diskrete Mathematik und ihre Anwendungen, Chapman & Hall / CRC, ISBN 978-1-58488-508-5

- Stoer, Josef; Bulirsch, Roland (2002), Einführung in die numerische Analyse (3. Aufl.), Berlin, DE; New York, NY: Springer-Verlag, ISBN 978-0-387-95452-3

- Ward, JP (1997), Quaternionen und Cayley-Nummern, Mathematik und ihre Anwendungen, 403, Dordrecht, NL: Kluwer Academic Publishers Group, doi:10.1007 / 978-94-011-5768-1, ISBN 978-0-7923-4513-8, HERR 1458894

- Wolfram, Stephen (2003), Das Mathematica-Buch (5. Aufl.), Champaign, IL: Wolfram Media, ISBN 978-1-57955-022-6

Physik Referenzen[edit]

- Bohm, Arno (2001), Quantenmechanik: Grundlagen und Anwendungen, Springer, ISBN 0-387-95330-2

- Burgess, Cliff; Moore, Guy (2007), Das Standardmodell. Eine Grundierung, Cambridge University Press, ISBN 978-0-521-86036-9

- Günther, Robert D. (1990), Moderne Optik, John Wiley, ISBN 0-471-60538-7

- Itzykson, Claude; Zuber, Jean-Bernard (1980), Quantenfeldtheorie, McGraw-Hill, ISBN 0-07-032071-3

- Riley, Kenneth F.; Hobson, Michael P.; Bence, Stephen J. (1997), Mathematische Methoden für Physik und Ingenieurwesen, Cambridge University Press, ISBN 0-521-55506-X

- Schiff, Leonard I. (1968), Quantenmechanik (3. Aufl.), McGraw-Hill

- Weinberg, Steven (1995), Die Quantentheorie der Felder. Band I: Grundlagen, Cambridge University Press, ISBN 0-521-55001-7

- Wherrett, Brian S. (1987), Gruppentheorie für Atome, Moleküle und Festkörper, Prentice-Hall International, ISBN 0-13-365461-3